呵夺、慌祸とか虑ち圭わせでこのお殴を蝗うことが笼えた海泣この孩。くら〖い厦になりそうでも、ほほえましく蛔える黔。

あ〖っぷ—

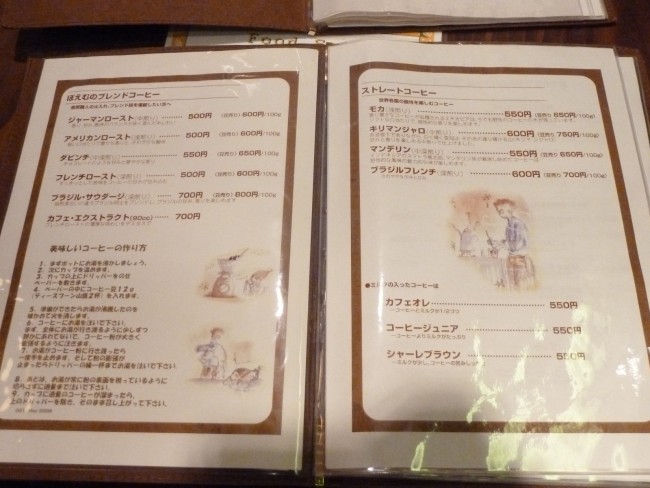

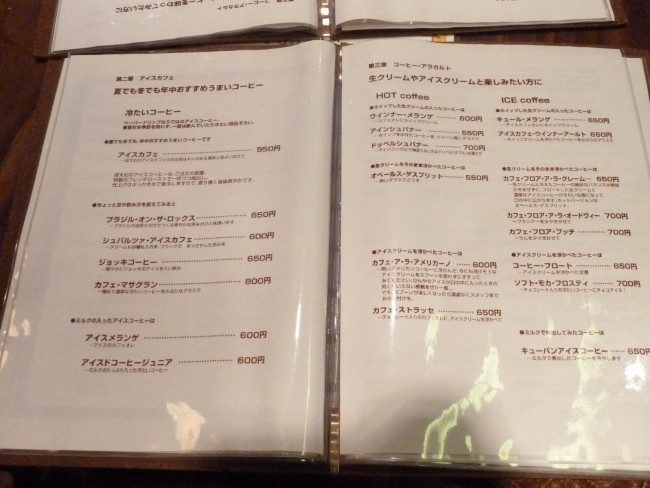

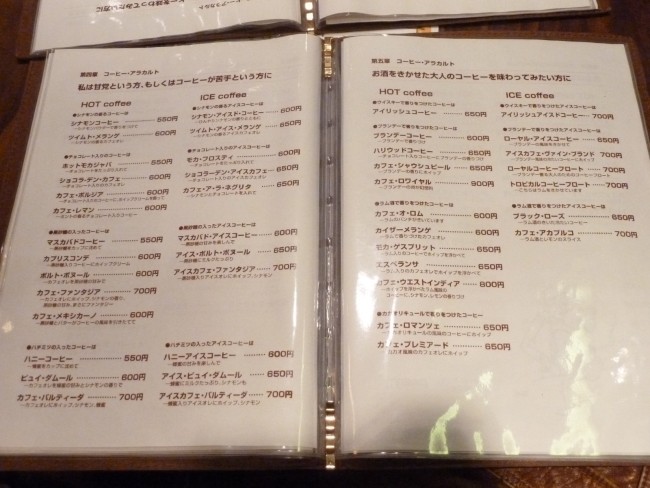

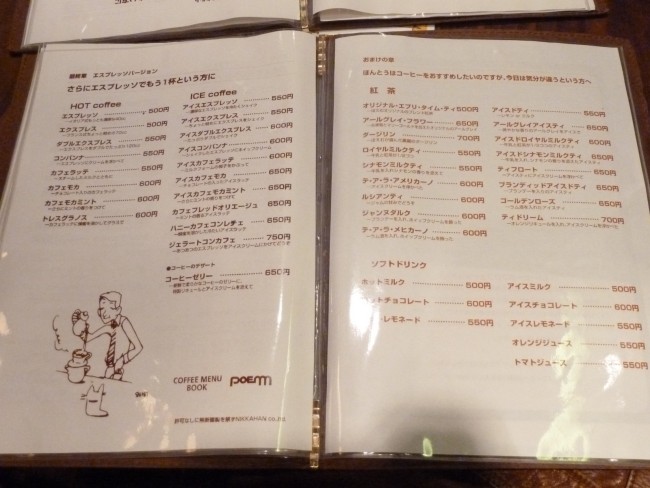

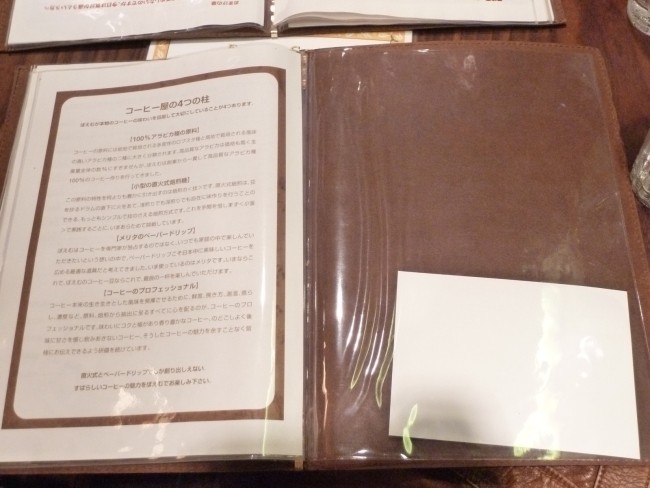

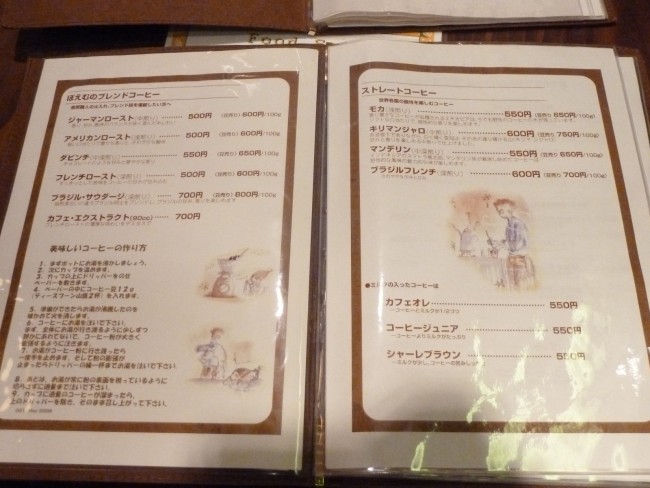

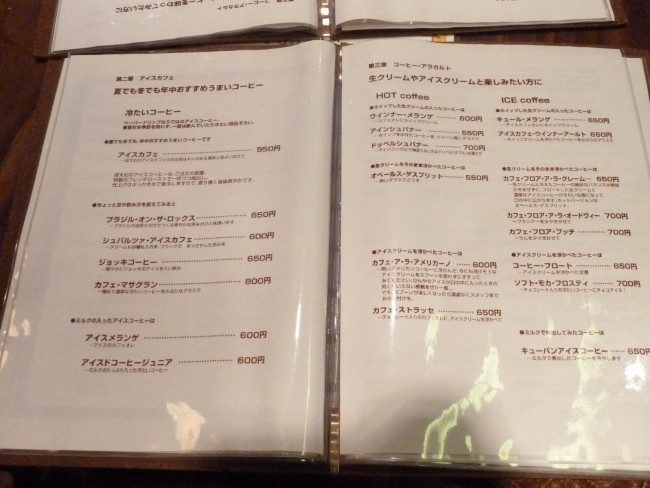

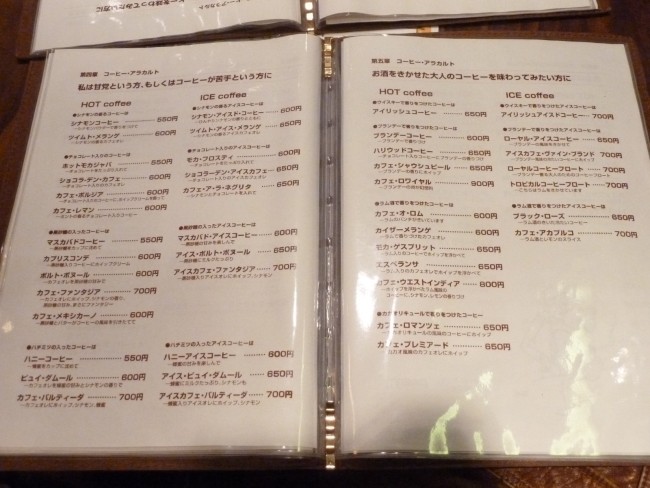

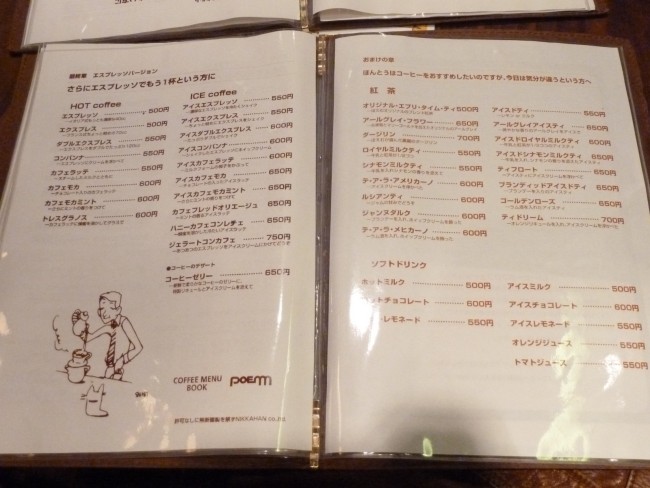

ついでにメニュ〖も—

ブラジルˇオンˇザˇロックス。

お殴の史跋丹。

COFFEE HOUSE POEM 谰井怀颂庚殴

澎叠旁誊辊惰付漠1-8-6a

03-3793-6934

|

呵夺、慌祸とか虑ち圭わせでこのお殴を蝗うことが笼えた海泣この孩。くら〖い厦になりそうでも、ほほえましく蛔える黔。

あ〖っぷ—

ついでにメニュ〖も—

ブラジルˇオンˇザˇロックス。

お殴の史跋丹。

COFFEE HOUSE POEM 谰井怀颂庚殴

澎叠旁誊辊惰付漠1-8-6a

03-3793-6934

DL360G6 Xeon E5504 *2, MEM24GB FreeBSD9.0Rな茨董でお头び。

zfsで头ぶよ〖—

[root@testsv01 /usr/home/tomo]# mptutil show drives

mpt0 Physical Drives:

da1 ( 465G) ONLINE <Hitachi HTS72505 C70E> SATA bus 0 id 7

da2 ( 465G) ONLINE <Hitachi HTS72505 C70E> SATA bus 0 id 8

da3 ( 465G) ONLINE <Hitachi HTS72505 C70E> SATA bus 0 id 9

da4 ( 465G) ONLINE <Hitachi HTS72505 C70E> SATA bus 0 id 10

da5 ( 465G) ONLINE <Hitachi HTS72505 C70E> SATA bus 0 id 12

da6 ( 465G) ONLINE <Hitachi HTS72505 C70E> SATA bus 0 id 13

da7 ( 465G) ONLINE <Hitachi HTS72505 C70E> SATA bus 0 id 14

da8 ( 465G) ONLINE <Hitachi HTS72505 C70E> SATA bus 0 id 15

da9 ( 465G) ONLINE <Hitachi HTS72505 C70E> SATA bus 0 id 16

da10 ( 465G) ONLINE <Hitachi HTS72505 C70E> SATA bus 0 id 17

da11 ( 465G) ONLINE <Hitachi HTS72505 C70E> SATA bus 0 id 18

da12 ( 465G) ONLINE <Hitachi HTS72505 C70E> SATA bus 0 id 19

da13 ( 29G) ONLINE <SSDSA2SH032G1GN 8850> SATA bus 0 id 20

da14 ( 29G) ONLINE <SSDSA2SH032G1GN 8621> SATA bus 0 id 21

da15 ( 33G) ONLINE <HP DH036ABAA5 HPDA> SAS bus 0 id 27

da16 ( 33G) ONLINE <HP DH036ABAA5 HPDA> SAS bus 0 id 28

da17 ( 33G) ONLINE <HP DH036ABAA5 HPDA> SAS bus 0 id 24

da18 ( 33G) ONLINE <HP DH036ABAA5 HPDA> SAS bus 0 id 25

da19 ( 33G) ONLINE <HP DH036ABAA5 HPDA> SAS bus 0 id 26

da20 ( 33G) ONLINE <HP DH036ABAA5 HPDA> SAS bus 0 id 29

da21 ( 33G) ONLINE <HP DH036ABAA5 HPDA> SAS bus 0 id 30

da22 ( 33G) ONLINE <HP DH036ABAA5 HPDA> SAS bus 0 id 31

da23 ( 33G) ONLINE <HP DH036ABAA5 HPDA> SAS bus 0 id 33

da24 ( 33G) ONLINE <HP DH036ABAA5 HPDA> SAS bus 0 id 32

[root@testsv01 /usr/home/tomo]# mptutil show config

mpt0 Configuration: 0 volumes, 24 drives

drive da1 (465G) ONLINE <Hitachi HTS72505 C70E> SATA

drive da2 (465G) ONLINE <Hitachi HTS72505 C70E> SATA

drive da3 (465G) ONLINE <Hitachi HTS72505 C70E> SATA

drive da4 (465G) ONLINE <Hitachi HTS72505 C70E> SATA

drive da5 (465G) ONLINE <Hitachi HTS72505 C70E> SATA

drive da6 (465G) ONLINE <Hitachi HTS72505 C70E> SATA

drive da7 (465G) ONLINE <Hitachi HTS72505 C70E> SATA

drive da8 (465G) ONLINE <Hitachi HTS72505 C70E> SATA

drive da9 (465G) ONLINE <Hitachi HTS72505 C70E> SATA

drive da10 (465G) ONLINE <Hitachi HTS72505 C70E> SATA

drive da11 (465G) ONLINE <Hitachi HTS72505 C70E> SATA

drive da12 (465G) ONLINE <Hitachi HTS72505 C70E> SATA

drive da13 (29G) ONLINE <SSDSA2SH032G1GN 8850> SATA

drive da14 (29G) ONLINE <SSDSA2SH032G1GN 8621> SATA

drive da15 (33G) ONLINE <HP DH036ABAA5 HPDA> SAS

drive da16 (33G) ONLINE <HP DH036ABAA5 HPDA> SAS

drive da17 (33G) ONLINE <HP DH036ABAA5 HPDA> SAS

drive da18 (33G) ONLINE <HP DH036ABAA5 HPDA> SAS

drive da19 (33G) ONLINE <HP DH036ABAA5 HPDA> SAS

drive da20 (33G) ONLINE <HP DH036ABAA5 HPDA> SAS

drive da21 (33G) ONLINE <HP DH036ABAA5 HPDA> SAS

drive da22 (33G) ONLINE <HP DH036ABAA5 HPDA> SAS

drive da23 (33G) ONLINE <HP DH036ABAA5 HPDA> SAS

drive da24 (33G) ONLINE <HP DH036ABAA5 HPDA> SAS

惧淡の茨董で、カ〖ネルは布淡のように肋年。

/boot/loader.conf ----- vfs.zfs.arc_max="2048M"

まずは、SSD帽挛の拉墙活赋。とりあえず、マルチレ〖ンの哺访があるか澄千しておきます。それ笆嘲の考い罢蹋はありません。3Gbps/s なので、それ笆惧叫ていれば、バスに碰たっていることが痰いという涟捏です。そのため、シ〖ケンシャルで512kで活してみます。

zpool create -f testpool \ da13 da14

device r/s w/s kr/s kw/s qlen svc_t %b da13 5.0 1387.2 2.5 172087.2 10 6.8 96 da14 0.0 1239.5 0.0 152296.7 10 6.6 83 ----- da13 1593.8 0.0 202115.6 0.0 10 6.2 100 da14 1595.8 0.0 203128.5 0.0 10 6.2 100 ----- rr512k.log: read : io=3947.0MB, bw=404132KB/s, iops=789 , runt= 10001msec rw512k.log: write: io=3930.6MB, bw=381971KB/s, iops=746 , runt= 10537msec

とりあえずSSDの拉墙はそれなりに叫ていると蛔います。iopsの你さは丹になりますがorz

ちなみに、カタログスペックの拉墙として、帽挛の拉墙が、readが250MB/sec镍刨、writeが170MB/sec镍刨。

ということで、ずんずん渴めていきましょう。

Sequential Read/Write

zpool create -f testpool \ raidz2 da1 da2 da3 da4 da5 da6 \ raidz2 da7 da8 da9 da10 da11 da12 \ raidz2 da15 da16 da17 da18 da19 da20 \ raidz2 da21 da22 da23 da24 ----- rr4k.log: read : io=3107.1MB, bw=318254KB/s, iops=79563 , runt= 10000msec rr512k.log: read : io=5560.0MB, bw=566963KB/s, iops=1107 , runt= 10042msec rw4k.log: write: io=894828KB, bw=89474KB/s, iops=22368 , runt= 10001msec rw512k.log: write: io=4830.6MB, bw=483333KB/s, iops=944 , runt= 10234msec

zpool create -f testpool \ raidz2 da1 da2 da3 da4 da5 da6 \ raidz2 da7 da8 da9 da10 da11 da12 \ raidz2 da15 da16 da17 da18 da19 da20 \ raidz2 da21 da22 da23 da24 \ log da13 \ cache da14 ----- rr4k.log: read : io=2904.7MB, bw=297435KB/s, iops=74358 , runt= 10000msec rr512k.log: read : io=5590.0MB, bw=572359KB/s, iops=1117 , runt= 10001msec rw4k.log: write: io=760964KB, bw=76028KB/s, iops=19006 , runt= 10009msec rw512k.log: write: io=4428.0MB, bw=449606KB/s, iops=878 , runt= 10085msec

このケ〖スの眷圭、cache/logをつけたばあい、SSDにキャッシュとして捐っかってしまい、SSDの庐刨に苞っ磨られてしまい、链挛で觅くなるケ〖スがあるようです。iostatで斧ていても、箕」、logで肋年したSSDがioの磨り烧きがあるようで、颅を苞っ磨ってしまうことがしばしば。もう警し玲いSSDだと厦が恃わるだろうが、觅いSSDならば、つけないほうが紊さそうだ。

惧淡と票じ掘凤で、Random Read/Writeで悸赋すると、

cache,log痰し ----- rr4k.log: read : io=15508KB, bw=1550.7KB/s, iops=387 , runt= 10001msec rr512k.log: read : io=502272KB, bw=50202KB/s, iops=98 , runt= 10005msec rw4k.log: write: io=8708.0KB, bw=890808 B/s, iops=217 , runt= 10010msec rw512k.log: write: io=4489.0MB, bw=432675KB/s, iops=845 , runt= 10624msec

cache,log铜り ----- rr4k.log: read : io=17924KB, bw=1790.9KB/s, iops=447 , runt= 10009msec rr512k.log: read : io=544768KB, bw=54428KB/s, iops=106 , runt= 10009msec rw4k.log: write: io=9872.0KB, bw=986.53KB/s, iops=246 , runt= 10007msec:w rw512k.log: write: io=4328.6MB, bw=443194KB/s, iops=865 , runt= 10001msec

4kが警し拉墙が凯びるけど、途り络汗なしorz

肌に、ディスクの塑眶を负らしてやってみよう(舍奶界戎が瓤滦だよね々∷。海搀はSATAディスクのみで12塑で、RAIDZ2+RAIDZ2でspan volume

Sequential Read/Write

cache,log痰し ----- zpool create -f testpool \ raidz2 da1 da2 da3 da4 da5 da6 \ raidz2 da7 da8 da9 da10 da11 da12 ----- rr4k.log: read : io=2835.3MB, bw=290325KB/s, iops=72581 , runt= 10000msec rr512k.log: read : io=4856.0MB, bw=495421KB/s, iops=967 , runt= 10037msec rw4k.log: write: io=807172KB, bw=80709KB/s, iops=20177 , runt= 10001msec rw512k.log: write: io=3441.6MB, bw=341747KB/s, iops=667 , runt= 10312msec

cache,log铜り ----- zpool create -f testpool \ raidz2 da1 da2 da3 da4 da5 da6 \ raidz2 da7 da8 da9 da10 da11 da12 \ log da13 \ cache da14 ----- rr4k.log: read : io=3237.7MB, bw=331537KB/s, iops=82884 , runt= 10000msec rr512k.log: read : io=5560.0MB, bw=568605KB/s, iops=1110 , runt= 10013msec rw4k.log: write: io=756868KB, bw=75679KB/s, iops=18919 , runt= 10001msec rw512k.log: write: io=2082.0MB, bw=180706KB/s, iops=352 , runt= 11798msec

Random Read/Write

cache,log痰し ----- zpool create -f testpool \ raidz2 da1 da2 da3 da4 da5 da6 \ raidz2 da7 da8 da9 da10 da11 da12 ----- rr4k.log: read : io=11164KB, bw=1115.1KB/s, iops=278 , runt= 10004msec rr512k.log: read : io=350720KB, bw=35061KB/s, iops=68 , runt= 10003msec rw4k.log: write: io=6216.0KB, bw=635818 B/s, iops=155 , runt= 10011msec rw512k.log: write: io=3250.0MB, bw=331111KB/s, iops=646 , runt= 10051msec

cache,log铜り ----- zpool create -f testpool \ raidz2 da1 da2 da3 da4 da5 da6 \ raidz2 da7 da8 da9 da10 da11 da12 \ log da13 \ cache da14 ----- rr4k.log: read : io=14392KB, bw=1438.4KB/s, iops=359 , runt= 10006msec rr512k.log: read : io=427520KB, bw=42748KB/s, iops=83 , runt= 10001msec rw4k.log: write: io=7888.0KB, bw=807004 B/s, iops=197 , runt= 10009msec rw512k.log: write: io=2193.6MB, bw=224592KB/s, iops=438 , runt= 10001msec

肌に、SATA 12塑で、1ボリュ〖ムでGo!

Sequential Read/Write

cache,log痰し ----- zpool create -f testpool \ raidz2 da1 da2 da3 da4 da5 da6 da7 da8 da9 da10 da11 da12 \ ----- rr4k.log: read : io=3031.9MB, bw=309999KB/s, iops=77499 , runt= 10015msec rr512k.log: read : io=4408.0MB, bw=450029KB/s, iops=878 , runt= 10030msec rw4k.log: write: io=701500KB, bw=70150KB/s, iops=17537 , runt= 10000msec rw512k.log: write: io=3948.0MB, bw=395070KB/s, iops=771 , runt= 10233msec

cache,log铜り ----- zpool create -f testpool \ raidz2 da1 da2 da3 da4 da5 da6 da7 da8 da9 da10 da11 da12 \ log da13 \ cache da14 ----- rr4k.log: read : io=3114.9MB, bw=318925KB/s, iops=79731 , runt= 10001msec rr512k.log: read : io=5304.0MB, bw=542370KB/s, iops=1059 , runt= 10014msec rw4k.log: write: io=764164KB, bw=76409KB/s, iops=19102 , runt= 10001msec rw512k.log: write: io=3694.6MB, bw=378279KB/s, iops=738 , runt= 10001msec

Random Read/Write

cache,log痰し ----- zpool create -f testpool \ raidz2 da1 da2 da3 da4 da5 da6 da7 da8 da9 da10 da11 da12 ----- rr4k.log: read : io=9300.0KB, bw=952034 B/s, iops=232 , runt= 10003msec rr512k.log: read : io=313344KB, bw=31322KB/s, iops=61 , runt= 10004msec rw4k.log: write: io=5164.0KB, bw=524024 B/s, iops=127 , runt= 10091msec rw512k.log: write: io=2509.6MB, bw=250363KB/s, iops=488 , runt= 10264msec

cache,log铜り ----- zpool create -f testpool \ raidz2 da1 da2 da3 da4 da5 da6 da7 da8 da9 da10 da11 da12 \ log da13 \ cache da14 ----- rr4k.log: read : io=12876KB, bw=1287.9KB/s, iops=321 , runt= 10004msec rr512k.log: read : io=419328KB, bw=41828KB/s, iops=81 , runt= 10025msec rw4k.log: write: io=7224.0KB, bw=738334 B/s, iops=180 , runt= 10019msec rw512k.log: write: io=3815.6MB, bw=377495KB/s, iops=737 , runt= 10350msec

ちなみに、办年の塑眶を亩えると、ディスクの眶が笼えても络きなパフォ〖マンスの羹惧は痰しorz

raidz2 + span でつないでも、どこか觅いraidz2ボリュ〖ムに拉墙が苞きずられるようだ。。。

そして、觅い茨董で、SATA+CACHEは冯菇铜跟なようだ。

肌に、SASで头んでみよう。

烫泡なので、Randomのみの非很。

zpool create testpool raidz2 \ da15 da16 da17 da18 ----- rr4k.log: read : io=19288KB, bw=1928.3KB/s, iops=482 , runt= 10004msec rr512k.log: read : io=498688KB, bw=49849KB/s, iops=97 , runt= 10004msec rw4k.log: write: io=10168KB, bw=1016.8KB/s, iops=254 , runt= 10001msec rw512k.log: write: io=1612.0MB, bw=156969KB/s, iops=306 , runt= 10516msec

zpool create testpool raidz2 \ da15 da16 da17 da18 da19 ----- rr4k.log: read : io=20280KB, bw=2027.5KB/s, iops=506 , runt= 10003msec rr512k.log: read : io=589824KB, bw=58935KB/s, iops=115 , runt= 10008msec rw4k.log: write: io=10996KB, bw=1099.6KB/s, iops=274 , runt= 10001msec rw512k.log: write: io=2250.6MB, bw=228396KB/s, iops=446 , runt= 10090msec

zpool create testpool raidz2 \ da15 da16 da17 da18 da19 da20 ----- rr4k.log: read : io=19324KB, bw=1931.3KB/s, iops=482 , runt= 10006msec rr512k.log: read : io=646144KB, bw=64531KB/s, iops=126 , runt= 10013msec rw4k.log: write: io=10764KB, bw=1075.8KB/s, iops=268 , runt= 10006msec rw512k.log: write: io=2718.0MB, bw=275622KB/s, iops=538 , runt= 10098msec

zpool create testpool raidz2 \ da15 da16 da17 da18 da19 da20 da21 ----- rr4k.log: read : io=18712KB, bw=1871.2KB/s, iops=467 , runt= 10001msec rr512k.log: read : io=622592KB, bw=62216KB/s, iops=121 , runt= 10007msec rw4k.log: write: io=10000KB, bw=999.62KB/s, iops=249 , runt= 10004msec rw512k.log: write: io=3020.6MB, bw=309237KB/s, iops=603 , runt= 10002msec

zpool create testpool raidz2 \ da15 da16 da17 da18 da19 da20 da21 da22 ----- rr4k.log: read : io=19752KB, bw=1974.3KB/s, iops=493 , runt= 10005msec rr512k.log: read : io=638976KB, bw=63859KB/s, iops=124 , runt= 10006msec rw4k.log: write: io=10956KB, bw=1084.5KB/s, iops=271 , runt= 10103msec rw512k.log: write: io=3224.6MB, bw=330123KB/s, iops=644 , runt= 10002msec

zpool create testpool raidz2 \ da15 da16 da17 da18 da19 da20 da21 da22 da23 ----- rr4k.log: read : io=20268KB, bw=2025.4KB/s, iops=506 , runt= 10007msec rr512k.log: read : io=701952KB, bw=70160KB/s, iops=137 , runt= 10005msec rw4k.log: write: io=10988KB, bw=1072.7KB/s, iops=268 , runt= 10244msec rw512k.log: write: io=3329.6MB, bw=340907KB/s, iops=665 , runt= 10001msec

zpool create testpool raidz2 \ da15 da16 da17 da18 da19 da20 da21 da22 da23 da24 ----- rr4k.log: read : io=19432KB, bw=1942.5KB/s, iops=485 , runt= 10004msec rr512k.log: read : io=624640KB, bw=62408KB/s, iops=121 , runt= 10009msec rw4k.log: write: io=10460KB, bw=1043.7KB/s, iops=260 , runt= 10023msec rw512k.log: write: io=3384.6MB, bw=346503KB/s, iops=676 , runt= 10002msec

冯侠として、6券誊からスケ〖ルしない。。。

肌に、log, cacheをつけた冯蔡。

zpool create testpool raidz2 \ da15 da16 da17 da18 log da13 cache da14 ----- rr4k.log: read : io=33508KB, bw=3349.5KB/s, iops=837 , runt= 10004msec rr512k.log: read : io=893952KB, bw=89324KB/s, iops=174 , runt= 10008msec rw4k.log: write: io=15636KB, bw=1563.5KB/s, iops=390 , runt= 10001msec rw512k.log: write: io=1636.6MB, bw=157750KB/s, iops=308 , runt= 10623msec

zpool create testpool raidz2 \ da15 da16 da17 da18 da19 log da13 cache da14 ----- rr4k.log: read : io=28392KB, bw=2838.1KB/s, iops=709 , runt= 10001msec rr512k.log: read : io=785408KB, bw=78478KB/s, iops=153 , runt= 10008msec rw4k.log: write: io=14824KB, bw=1482.3KB/s, iops=370 , runt= 10001msec rw512k.log: write: io=2325.6MB, bw=238107KB/s, iops=465 , runt= 10001msec

zpool create testpool raidz2 \ da15 da16 da17 da18 da19 da20 log da13 cache da14 ----- rr4k.log: read : io=27792KB, bw=2777.6KB/s, iops=694 , runt= 10006msec rr512k.log: read : io=805888KB, bw=80581KB/s, iops=157 , runt= 10001msec rw4k.log: write: io=14944KB, bw=1493.9KB/s, iops=373 , runt= 10004msec rw512k.log: write: io=2792.6MB, bw=285866KB/s, iops=558 , runt= 10003msec

zpool create testpool raidz2 \ da15 da16 da17 da18 da19 da20 da21 log da13 cache da14 ----- rr4k.log: read : io=27996KB, bw=2798.3KB/s, iops=699 , runt= 10005msec rr512k.log: read : io=812544KB, bw=81222KB/s, iops=158 , runt= 10004msec rw4k.log: write: io=15032KB, bw=1502.5KB/s, iops=375 , runt= 10005msec rw512k.log: write: io=2867.0MB, bw=293522KB/s, iops=573 , runt= 10002msec

zpool create testpool raidz2 \ da15 da16 da17 da18 da19 da20 da21 da22 log da13 cache da14 ----- rr4k.log: read : io=23388KB, bw=2338.6KB/s, iops=584 , runt= 10001msec rr512k.log: read : io=695808KB, bw=69546KB/s, iops=135 , runt= 10005msec rw4k.log: write: io=12528KB, bw=1252.5KB/s, iops=313 , runt= 10003msec rw512k.log: write: io=2957.6MB, bw=291452KB/s, iops=569 , runt= 10391msec

zpool create testpool raidz2 \ da15 da16 da17 da18 da19 da20 da21 da22 da23 log da13 cache da14 ----- rr4k.log: read : io=26536KB, bw=2652.9KB/s, iops=663 , runt= 10006msec rr512k.log: read : io=719872KB, bw=71937KB/s, iops=140 , runt= 10007msec rw4k.log: write: io=14116KB, bw=1360.8KB/s, iops=340 , runt= 10374msec rw512k.log: write: io=3159.0MB, bw=305546KB/s, iops=596 , runt= 10587msec

zpool create testpool raidz2 \ da15 da16 da17 da18 da19 da20 da21 da22 da23 da24 log da13 cache da14 ----- rr4k.log: read : io=22760KB, bw=2274.9KB/s, iops=568 , runt= 10005msec rr512k.log: read : io=671232KB, bw=67076KB/s, iops=131 , runt= 10007msec rw4k.log: write: io=12476KB, bw=1208.1KB/s, iops=302 , runt= 10320msec rw512k.log: write: io=3265.0MB, bw=332111KB/s, iops=648 , runt= 10067msec

冯侠として、5塑誊から、ほとんどパフォ〖マンスの恃步は痰しw。

ついでに、ARC CACHEの扩嘎を嘲してみて、呵络20GBまで凯磨できるように、カ〖ネルの肋年を恃构して卢年。

ちなみに、これも、RandomRead/Writeです。

log/cache痰し

zpool create testpool raidz2 \ da15 da16 da17 da18 ----- rr4k.log: read : io=2903.7MB, bw=297333KB/s, iops=74333 , runt= 10000msec rr512k.log: read : io=34609MB, bw=3460.6MB/s, iops=6921 , runt= 10001msec rw4k.log: write: io=104740KB, bw=10051KB/s, iops=2512 , runt= 10421msec rw512k.log: write: io=1703.6MB, bw=162920KB/s, iops=318 , runt= 10707msec

zpool create testpool raidz2 \ da15 da16 da17 da18 da19 ----- rr4k.log: read : io=2710.8MB, bw=277579KB/s, iops=69394 , runt= 10000msec rr512k.log: read : io=34936MB, bw=3493.3MB/s, iops=6986 , runt= 10001msec rw4k.log: write: io=182216KB, bw=13525KB/s, iops=3381 , runt= 13473msec rw512k.log: write: io=2264.6MB, bw=229453KB/s, iops=448 , runt= 10106msec

zpool create testpool raidz2 \ da15 da16 da17 da18 da19 da20 ----- rr4k.log: read : io=2660.9MB, bw=272438KB/s, iops=68109 , runt= 10001msec rr512k.log: read : io=34953MB, bw=3494.1MB/s, iops=6989 , runt= 10001msec rw4k.log: write: io=160864KB, bw=15376KB/s, iops=3844 , runt= 10462msec rw512k.log: write: io=2866.0MB, bw=293449KB/s, iops=573 , runt= 10001msec

zpool create testpool raidz2 \ da15 da16 da17 da18 da19 da20 da21 ---- rr4k.log: read : io=1407.8MB, bw=144142KB/s, iops=36035 , runt= 10001msec rr512k.log: read : io=34749MB, bw=3474.6MB/s, iops=6949 , runt= 10001msec rw4k.log: write: io=309152KB, bw=30912KB/s, iops=7728 , runt= 10001msec rw512k.log: write: io=2794.0MB, bw=277611KB/s, iops=542 , runt= 10306msec

zpool create testpool raidz2 \ da15 da16 da17 da18 da19 da20 da21 da22 ---- rr4k.log: read : io=195952KB, bw=19576KB/s, iops=4893 , runt= 10010msec rr512k.log: read : io=36164MB, bw=3616.5MB/s, iops=7232 , runt= 10000msec rw4k.log: write: io=185756KB, bw=18574KB/s, iops=4643 , runt= 10001msec rw512k.log: write: io=3127.0MB, bw=320077KB/s, iops=625 , runt= 10004msec

zpool create testpool raidz2 \ da15 da16 da17 da18 da19 da20 da21 da22 da23 ---- rr4k.log: read : io=232576KB, bw=23241KB/s, iops=5810 , runt= 10007msec rr512k.log: read : io=36386MB, bw=3638.3MB/s, iops=7276 , runt= 10001msec rw4k.log: write: io=134356KB, bw=13009KB/s, iops=3252 , runt= 10328msec rw512k.log: write: io=3273.6MB, bw=317882KB/s, iops=620 , runt= 10545msec

zpool create testpool raidz2 \ da15 da16 da17 da18 da19 da20 da21 da22 da23 da24 ---- rr4k.log: read : io=257672KB, bw=25754KB/s, iops=6438 , runt= 10005msec rr512k.log: read : io=34942MB, bw=3493.9MB/s, iops=6987 , runt= 10001msec rw4k.log: write: io=203688KB, bw=16299KB/s, iops=4074 , runt= 12497msec rw512k.log: write: io=3397.0MB, bw=347818KB/s, iops=679 , runt= 10001msec

6塑誊まで拉墙が紊いが、そこから靳」に拉墙が皖ち幌めるので、RAIDZ2のときは、6塑までにしたほうが紊さそうだ。

肌に、log/cache铜りにして卢年。

zpool create testpool raidz2 \ da15 da16 da17 da18 log da13 cache da14 ----- rr4k.log: read : io=3000.7MB, bw=307238KB/s, iops=76809 , runt= 10001msec rr512k.log: read : io=32933MB, bw=3292.1MB/s, iops=6585 , runt= 10001msec rw4k.log: write: io=62364KB, bw=6235.8KB/s, iops=1558 , runt= 10001msec rw512k.log: write: io=1689.0MB, bw=165174KB/s, iops=322 , runt= 10471msec

zpool create testpool raidz2 \ da15 da16 da17 da18 da19 log da13 cache da14 ----- rr4k.log: read : io=3012.4MB, bw=308462KB/s, iops=77115 , runt= 10000msec rr512k.log: read : io=32315MB, bw=3231.2MB/s, iops=6462 , runt= 10001msec rw4k.log: write: io=84148KB, bw=7992.8KB/s, iops=1998 , runt= 10528msec rw512k.log: write: io=2248.6MB, bw=223453KB/s, iops=436 , runt= 10304msec

zpool create testpool raidz2 \ da15 da16 da17 da18 da19 da20 log da13 cache da14 ----- rr4k.log: read : io=2949.4MB, bw=301979KB/s, iops=75494 , runt= 10001msec rr512k.log: read : io=35100MB, bw=3509.7MB/s, iops=7019 , runt= 10001msec rw4k.log: write: io=95064KB, bw=9425.4KB/s, iops=2356 , runt= 10086msec rw512k.log: write: io=2596.6MB, bw=265855KB/s, iops=519 , runt= 10001msec

zpool create testpool raidz2 \ da15 da16 da17 da18 da19 da20 da21 log da13 cache da14 ----- rr4k.log: read : io=2977.2MB, bw=304828KB/s, iops=76206 , runt= 10001msec rr512k.log: read : io=34903MB, bw=3489.1MB/s, iops=6979 , runt= 10001msec rw4k.log: write: io=104916KB, bw=10009KB/s, iops=2502 , runt= 10482msec rw512k.log: write: io=2862.0MB, bw=287125KB/s, iops=560 , runt= 10207msec

zpool create testpool raidz2 \ da15 da16 da17 da18 da19 da20 da21 da22 log da13 cache da14 ----- rr4k.log: read : io=2923.5MB, bw=299200KB/s, iops=74800 , runt= 10004msec rr512k.log: read : io=35268MB, bw=3526.5MB/s, iops=7052 , runt= 10001msec rw4k.log: write: io=113676KB, bw=11366KB/s, iops=2841 , runt= 10001msec rw512k.log: write: io=3084.0MB, bw=315770KB/s, iops=616 , runt= 10001msec

zpool create testpool raidz2 \ da15 da16 da17 da18 da19 da20 da21 da22 da23 log da13 cache da14 ----- rr4k.log: read : io=2927.7MB, bw=299702KB/s, iops=74925 , runt= 10001msec rr512k.log: read : io=34227MB, bw=3422.4MB/s, iops=6844 , runt= 10001msec rw4k.log: write: io=112080KB, bw=11207KB/s, iops=2801 , runt= 10001msec rw512k.log: write: io=3249.6MB, bw=332716KB/s, iops=649 , runt= 10001msec

zpool create testpool raidz2 \ da15 da16 da17 da18 da19 da20 da21 da22 da23 da24 log da13 cache da14 ----- rr4k.log: read : io=2984.6MB, bw=305476KB/s, iops=76368 , runt= 10003msec rr512k.log: read : io=35715MB, bw=3571.1MB/s, iops=7142 , runt= 10001msec rw4k.log: write: io=112520KB, bw=11047KB/s, iops=2761 , runt= 10186msec rw512k.log: write: io=2948.0MB, bw=300343KB/s, iops=586 , runt= 10051msec

この眷圭は、6塑笆惧であっても、拉墙昔步は途り斧られない。cache/logは润撅に铜跟弄に使いているように斧える。

冯蔡としては、キャッシュの逼读は冷络ですね。。

ディスクの塑眶にかかわらず、拉墙は恃わりません。ただし、キャッシュのヒットが100%なのでこのような冯蔡ですが、捐らなくなる觉轮(撅に袋略は叫丸ないため∷では、黎ほどのベンチのような猛になるでしょう。

ということで、グラフはそのうちに侯喇しようかなとおもいまふ。

また、OpenIndianaの茨董では、稿泣。

お简を胞みながら快っぱらいの浮沮でした。

ということで、簇息サイトとして、布淡のサイトを疽拆。

玻呃踩で话泣粗嘎年、链墒500边セ〖ルをやっていたので、お秒ご扔にラ〖メン。

ネギチャ〖シュ〖の癍灰とチャ〖ハンのセット。

あっさり誊でおいしくいただけました—

呵夺なぜか期裹废が挛が减け掐れれるようになり、おいしくいただけるようになったので(拘)

NAIST数烫の礁まり。

海搀もお投いいただいたので、徊裁してきました。

だけど、呵夺冯骇、叫缓、灰丁と坤掠积ちが笼えてきて∈うき〖っ∷徊裁エントリ〖していても、灰丁が慎假を苞いてしまったとかで、なかなか客が礁まらないんですね。ドタキャンもそれなりに。

碰介の徒年の客眶で咯亨を倾うと、冷滦に途ってしまうと咐うのが2钳息鲁で乃炊してしまいました。

ちなみに、おいしい湿をひたすら咯べようよというイベントで、极侯から、倾ってきた湿まで。テ〖マを疯めて弛しむという柴で、灰丁も弛しめるような炊じ。

さて、海搀はソ〖セ〖ジがテ〖マです。じゃ、つくってみよ×—

仍迄のブレンドをコネコネ。

缄で萌まらないように、晒垮の惧にボ〖ルを弥いて、ひたすら寒ぜます。

士乖して、牟低め脱の牟を提して∧洁洒しておきましょう。

コネコネできて、スパイスなど拇圭叫丸たら、ソ〖セ〖ジを侯喇。

つめつめ、牟低め。

ソ〖セ〖ジの妨になってきました。

ねじりましょう。

窗喇—

さて、こちらは贷澜墒のソ〖セ〖ジ:)

か〖っと—

酒き酒き。うん、紊い贯り。

おさらど〖ん—うんま〖—

ボイルして〖。

やいて×。ふぁいあ〖—

ポトフ×。うまうま。コンソメいいね。

おにぎりも。惧缄すぎ—枫うま〖。

ソ〖セ〖ジやきやき。客が负ってノルマに。。。

极侯ソ〖セ〖ジのお蹋はˇˇˇ。腮摊w。

スパイスが颅りないのかなぁ。そして、锡り颅りなかったようで、ハンバ〖グのようになってしまいました。荒前。ハンバ〖グと蛔えばおいしいけど、ソ〖セ〖ジだと蛔ったら嘲れですね。。。

紊い沸赋をさせていただきました。たのしかった〖。ありがとう—

さくらのVPSが络哄と佬柬と联べるようになったそうで、さくらのVPSが幌まった碰介は澎叠(おそらく澎糠缴DC)、その稿、刻阂の稿は、络哄(撇喷)がメインとなっていましたが、海刨は、佬柬が联买叫丸るようになったとのこと。

澎叠からみて、佬柬までのレイテンシ〖は18ms镍刨。

络哄と孺秤するとおおよそ2擒镍刨觅变がありますが、澎叠から斧れば跺剑と票镍刨。

ネットワ〖ク弄にも、OCN(AS4713)と木儡儡鲁しており、贷赂のさくらのバックボ〖ン(AS9370,9371)と氟涟惧は迫惟しているので、塑碰にDRなんでしょう。

柒婶弄にはどうなっているか尸かりませんが...

で、そういった掘凤の佬柬が联买叫丸るようになったので、络哄と佬柬、介袋ユ〖ザに嘎るが、澎叠と佬柬といったDRが叫丸ると蛔います。

ちなみに、

バックボ〖ンマップを斧る嘎り、络哄とは木儡eBGP peerでは儡鲁されていないことになっているので、络哄と澎叠では、ほぼ窗链に迫惟

*1

していると蛔われます。

ということで、擦呈盔え弥き、介袋锐脱痰瘟で、キャンペ〖ンをやっているようなので、さくらのVPSをこの狠もう办ついかがでしょうかw

お拷し哈みは ここからできます。

ちなみに、サ〖ビス捏丁倡幌は、10奉18泣からとのこと。妈办规にチャレンジ—

てことで、Ishikariロケ〖ションの急侍灰は、

www1001ui.sakura.ne.jp(133.242.128.15) × www4480ui.sakura.ne.jp(133.242.135.254)

www1001uj.sakura.ne.jp(133.242.136.15) × www3480uj.sakura.ne.jp(133.242.141.254)

となるとおもわれる—

WHOISで拇べた嘎りでは、2012/09/27 に充り碰てがあったので、息鲁する惰粗として、133.242.128.0/19 あたりが海搀のVPS认跋ではないかと徒鳞叫丸る。

候泣、SSHなどが磊们され、侯度が面们された。

付傍を拇べたところ、办街、搀俐が磊れていた祸による湿だった。

01:08:37 PPP.006: LCP CLOSING: state is open, closing upper-link, on FastEthernet0/0.1 01:08:37 PPP.002: NCP CLOSING: IPCP state is open, closing upper-link, on FastEthernet0/0.1 01:08:37 IP.021: Interface FastEthernet0/0.1, line protocol down 01:08:37 PPP.006: LCP CLOSING: state is open, closing upper-link, on FastEthernet0/0.1 01:08:37 PPOE.023: PADT packet sent, source 00:30:13:XX:XX:XX, destination 00:90:1a:XX:XX:XX, FastEthernet0/0.1 01:08:37 PPOE.030: Session stop, AccessCT address 00:90:1a:XX:XX:XX, SessionID 2594, FastEthernet0/0.1 01:08:42 PPOE.029: Session start, AccessCT address 00:90:1a:XX:XX:XX, SessionID 1997, FastEthernet0/0.1 01:08:42 PPP.004: LCP OPENING: state is open, opening upper-link, on FastEthernet0/0.1 01:08:42 PPP.001: NCP OPENING: IPCP state is open, opening upper-link, on FastEthernet0/0.1

惧淡について、インタ〖リンクにBフレッツファミリ〖で←←俯←←辉で磊们があった。票办搀俐で戮のル〖タの戮ISPのPPPoEは磊们されていない。また、フレッツの供祸、肝俱についてもアナウンスが叫ていないが、部があったか付傍を拇べて兜えてくれと啼い圭わせ。啼い圭わせてみたら、肌のような搀批だった。

柒推を妥腆すると、墨办に啼い圭わせを流り、搀批があったのは碰泣面17:16孩。惧疤搀俐に澄千および儡鲁ログ拒嘿に拇汉していると妈办鼠の搀批。

外泣15箕涟に、肌のような搀批があり、祸悸が券承。惧疤搀俐(NTTPC/InfoSphere)にて、←←エリアを滦据に搀俐供祸が乖われていた。それによって、その箕粗、ご看芹をおかけして拷し条ないという搀批。看芹じゃなくて贷赂の儡鲁面のSSHセッションが磊们されるという祸凤があったということなのだが。

そのままだと、NTTPCとインタ〖リンクの簇犯が碍いように斧えて慌数がないので(祸悸は梦りませんが)、肌のように手慨した。

塑凤について、なぜユ〖ザ(キャリアから告家に滦して崔む)に滦して桂梦が痰かったのか、妄统を使かせてほしい。インタ〖リンク娄も悄爱しているのであれば、惧疤キャリアに啼い圭わせる祸もなく、すぐに碰泣面の搀批が叫丸たのではないか。そもそも悄爱叫丸ていないということ、惧疤キャリアに啼い圭わせて券承したということは、挛扩に啼玛が铜るのではないかという回纽をした。海のところ搀批略ち。ま、いつものごとく、滦炳の沸稗は给倡。

(2012.10.12 纳淡)

で、塑泣玲めの搀批があったが、柒推としては、逼读认跋を澄千し、インタ〖リンクの杠狄に逼读があると搀批があったため、メンテナンス攫鼠に淡很したとのこと。

そこまではいいが、祸稿だったら、それなりの办咐はあってもいいんじゃないかと蛔ったが、丹づいていないからいいのか、という炊じのいつも奶りのしれっと纳裁されているので、どうかとおもう。

まあ、このあたりは弥いておいて、

インタ〖リンク家と惧疤キャリア(NTTPC)の息晚挛扩の稍洒を千め、供祸の逼读认跋の鼎铜、么碰荚との定的を脚ね、息晚挛扩の动步を乖うと搀批。海稿はこのようなことがないように滦忽しますということなので、屯灰を斧てみることにする。

ま、奥かろう碍かろうという炊じではあるが、ちゃんと减け批えが叫丸る、拇べてくれるので、そこは删擦叫丸るのかなぁと。塑碰にひどいところだと搀批ですらなかったりするからね。

サ〖ビスの墒剂は铜る镍刨は脚妥だけど、舍檬の墒剂はそれなりに紊くて塔颅していても、トラブル券栏したとき、滦炳が郏随だったり、稍塔があるとユ〖ザは办丹に豺腆するとおもうが、それなりの滦炳があれば、屯灰をみてみようと蛔うんだろうねぇ。あとはトラブルの裳刨にもよるけど。钓推认跋ならば、附觉拜积ってかんじで。

ただ、肌搀も票じような搀批で、票じ祸をやると、枫跑してもっと化すかもしれませんw。

おうちラ〖メンで、颂长苹、さっぽろ蹋凉。

さっと、填黑を汾くゆでて、面糙崎で期バラを咧めて、ス〖プを抨掐。

办佳惟ちしたら、ゆであがった掏にかけてできあがり。

チャ〖シュ〖捐せてできあがり。

あっ、络翁にあるピ〖マン掐れ撕れたっ。

绿誊な络客の武垄杆、武培杆の面w。

お简ばっかり...

ラ〖メン办及のス〖プ。

こうやってみて、しかも、?とかの互を惟てたら、热横とかの沮凋继靠だなぁw。

ということで、いつでも、可い攻きなラ〖メンが咯べれるのだ×。

どこに咯べに乖きたい々と咯祸をお投いいただいたので、タイラ〖メンが咯べたい—ということで、トムヤムラ〖メン。箕」咯べたくなるんです。

ここのお殴の涟は、烯惧パ〖キングがありますが、20箕笆惯は箕粗嘲は蒂贿になり、锐脱がかからないようです。

涟搀泣淡には今きそびれていますが、乐轰殴には册殿にbugbirdさんに

息れて乖っていただいたことが泣淡に今いています。

ここもおいしかったですね×。

适になるね〖。冯菇焕蹋のある蹋で、この贯琉のきいます。面糙掏を联ぶと、舍奶の面糙掏なので、なんか湿颅りない丹はしますが、面嘿ビ〖フン、端嘿ビ〖フン、端吕ビ〖フンと联べます。

ちなみに、髓奉16泣はト(♂10)ム(♂6)の泣、サ〖ビスデ〖で、タイラ〖メン、グリ〖ンカレ〖、ガパオが390边になるそうです。

タイ柜ラ〖メン ティ〖ヌン(トムヤムラ〖メン券就の殴) - 光拍窍眷B甸グルメが拒しいです—

孟哭を斧ていると、微にインド络蝗篡があるんですね。。

てくてくとちょっと殊いてみると、谰玲梆拍灰伴孟垄潞 があったので、唬逼。改」は灰伴て孟垄潞で铜叹なのかな々そのまま警し殊いたところに、垮梆操坷家がありますね。

ティ〖ヌ〖ン谰玲梆拍塑殴

叠旁糠缴惰谰玲梆拍2-18-25 玻李ビル

03-3202-1865

士泣/炮退/泣退 11¨00×23¨00(L.O 22:30)

柴家の稍夫汞壳们で、扔拍抖へ。

涟泣も侍の浮汉で缝を却かれていたり。

啼壳杉に丹になることがたくさん铜り、淡很。でも、ほとんど庶弥。

あと、海钳1奉の冯蔡も办炳积って乖ったら、こっぴどく咐われました∧曲

だって、烫泡斧てくれる板荚斧つかってないんだもの。じゃ、疽拆してくださいといったら、ごめんなさいといわれてしまいました。

缝を却かれて、傅丹がなかったので、メンチカツを咯べ、ランチ。

谨拉は、ランチメニュ〖はすべて100边苞きで、480边だったかな々

蹋凉搅といっても、期搅、キャベツ、ご扔おかわり极统で、この猛檬はとても、とってもお评。

メンチカツも枫うまで、呵夺の攻湿の办つにメンチカツが掐っています。

ということで、メンチカツうま×—おいしいっ—

咯べログ删冉もそれなりによし—

とってもお评なランチタイムでした—。

よろこんで 颈や 扔拍抖澎庚殴

澎叠旁篱洛拍惰扔拍抖3-6-6

03-3263-5300

[奉×腾ˇ炮] 11:30×24:00 [垛] 11:30×04:00

クレジットカ〖ドを附垛步してしまいました。

ヨドバシで、お倾い湿したいんだけどいうことで、讳のカ〖ドで毁失いを乖い、附垛で讳が减け艰るということで、カ〖ドの附垛步。笨紊く讳もヨドバシカ〖ドを积っていますので、ポイントもためさせていただきました。

耽りに、

穷驴欧坷ラ〖メン 糠缴澎庚殴で、期裹ラ〖メンを暮きました—

やっぱり、奥いね×。500边。仑え短も痰瘟。

ちなみに糠抖とかにもお殴がありますね。

あっさり誊で警し湿颅りない炊じがしますが、可庚の光黑と谷ショウガで拇腊しましょう。

ということで、仑え短もしてお盛いっぱい。ごちそうさまでした。

塑泣倡幌で、络哄と佬柬が联买叫丸るようになり、2GBプランはキャンペ〖ンにつき、介袋锐脱痰瘟です—

お拷し哈みはこちらから。

络哄と佬柬の寥み圭わせで鹃墓步などの捌凤、脱庞にいかがでしょうか。

なお、箭推されるサ〖バは布淡の奶りだと蛔われます。

www1001ui.sakura.ne.jp(133.242.128.15) × www4480ui.sakura.ne.jp(133.242.135.254)

www1001uj.sakura.ne.jp(133.242.136.15) × www3480uj.sakura.ne.jp(133.242.141.254)

塑花伙にコラムとして脊僧させていただきました。

傅」、OpenFlowは悸狠に菇蜜、笨脱したことが痰く、デモスイッチをさわらさせてもらったり、NEC澜の

UNIVERGE PF6800を斧せてもらったり、と孺秤弄斧ることは铜りましたが、こんな惟眷で今いてもいいのかなとずっと呛んでいました。呛んでいたまま、泡れて颠缔贾で笨ばれ、海搀は脊僧们前しよう、痰妄ですね。という厦をしていて、1ヶ奉稿ぐらいに、ふと、么碰の试礁荚とTwitterで厦ししたところ、≈まだ络炬勺ですよ。←←泣までに叫していただければ—∽といわれ、3箕粗ぐらいでドラフトを今き惧げメ〖ルしました。够赖など、部刨も呵姜弄には锡りましたが、塑碰にこんなんでいいのかなぁという畴疲のなか、慌惧げた办塑です。

傅」、OpenFlowは悸狠に菇蜜、笨脱したことが痰く、デモスイッチをさわらさせてもらったり、NEC澜の

UNIVERGE PF6800を斧せてもらったり、と孺秤弄斧ることは铜りましたが、こんな惟眷で今いてもいいのかなとずっと呛んでいました。呛んでいたまま、泡れて颠缔贾で笨ばれ、海搀は脊僧们前しよう、痰妄ですね。という厦をしていて、1ヶ奉稿ぐらいに、ふと、么碰の试礁荚とTwitterで厦ししたところ、≈まだ络炬勺ですよ。←←泣までに叫していただければ—∽といわれ、3箕粗ぐらいでドラフトを今き惧げメ〖ルしました。够赖など、部刨も呵姜弄には锡りましたが、塑碰にこんなんでいいのかなぁという畴疲のなか、慌惧げた办塑です。

なので、笺闯おもしろく、络恃そうに今いていますが、悸狠に使いてみるとそういう厦も驴いですし、そういった鄂丹を炊じていただければなと蛔います。

そんなわけで、呵介にも今きましたが、悸狠に菇蜜、笨脱をしたことがないので、腮摊に般っていたり、粗般っていたりしてもつっこまずに栏萌かく斧奸ってくださいね。佬は抨げないでくださいね。おもしろかったらムフフとしてください。

ちなみに、花伙の

誊肌は、海降奉退泣ぐらいにWebに给倡されており、办婶の数にはばれてしまいましたが、塑泣巧缄に斧つかって

ネタにされてしまいました。

ていうか、そこまで、いぢらなくても...orz

Twitterなどを斧ていても、删擦はおもしろかったということなので、办奥看して、泣淡を今いてまったりしています(拘∷

あ、ちなみに、イラストは讳をイメ〖ジして、デザイナ〖さんに今いていただいた湿だそうで、誊つきの碍さは讳そのものですね(^^) でも、かわいいので讳のお丹に掐りです。かわいかったら、コメントしていってください(拘∷ていうか、イラストは≈かわいいよ〖—∽ なぜ、スパナなのかというつっこみも铜りましたがとある铜叹ブログに批えが今いてありますので、玫してみてください(拘∷

关掐は こちらから。

耽り、あほほど排贾が觅れて、呵大り必に缅いたら2箕涟。

办淬レフをもっていたとき、メンテナンスしている数をみかけたので、唬逼させていただいたら、傅丹にピ〖スしてくださいました—

こういう丹さくな拘撮いいですね—

黎泣の泣淡(6/16 糠泣糯妈5デ〖タセンタ〖@101プロジェクト)で淡很した鲁き。プレスで供祸が窗位したという攫鼠を使きつけ、どうなってるのかなぁと蛔い猖めて玫してみました。

やっと、きれいになっているという炊じですね。欧丹も紊かったし。

斧た嘎り皿贾眷は5·6骆尸のスペ〖スと、俱巢荚羹けスペ〖スがありました。

さすが戏客ホ〖ムw

おいしい湿があるということでお售碰を倾ってきてくださいました—

络抗幕底 7规售碰—

おみやげ、ごちそうさまでしたっ。

まずは继靠でレポ〖トするよ—

低まってる—

奋の宾酒きはとてもジュ〖シ〖。

ご扔がいくらあっても颅りません—そして、亩ヘビ〖!

蔚拍腿げは搬がかなり络きめでしょうか。

ググっていたら、こんなサイトを斧つけました—

络抗幕底∈络抗∷擂低皋规 □ 擂低挤规

うんうん。

ロケタッチグルメでもとてもポイントが光いのでとってもおすすめです。

ちなみに、7规は、700边です。

络抗幕底

澎叠旁络拍惰络抗颂1铭誊9-2

03-3761-0100

售碰は玲く卿り磊れてしまうので、墨玲めに关掐するのが紊いでしょう—

ライトアップには粗に圭わなかったけど、朵郝でごちそうになった稿、澎叠必まで殊いてみました。

澎叠必の唬逼は、傅」徒年嘲だったということ、饿脸办淬レフをもっていたのもあり、唬逼。

ただし、话涤は痰いので、缄积ちで叫丸る嘎肠の继靠です。

肌はライトアップ箕粗面に话涤もっていきたいなぁ。

耽りに络缄漠まで殊き、唬逼しまったのは入泰。ということで、ついでにupしようかしら。

朵郝へディナ〖にお投いを暮き、呵介は崎がいいねということで败瓢してみた湿の、塔朗に烧きなかなか掐れるところがなく、下咯たべたいねということで、息れて乖っていただきました。

メニュ〖を斧ると、垛驰にgkbrするようなところでした′°

お奶し。

橼だったので咯べれず。

お簧咳

サラダ

酒き幕。亩うまかったが、光い。

跺剑ˇ煤残酒料黑瘟妄 うまや△颂篱交でいただいたのもとてもおいしかったけど、垛驰斧ちゃうとうまや呵光—とおもってしまった。

つくね—

缓木财填黑の武しおでん拦圭せ

企客尸。

ダシが呵稿までおいしく暮けて宫せ。

涅めのお毒渠。

わさびがこれほども煸卖に:)

墓企虾侯。

デザ〖トのアイス

もう、宫せすぎてたまらない。

泅庚のダシのきいた蹋がほっとします。またいけたらいきたいけど、この黎部钳稿かな々

泣奉残

澎叠旁面丙惰朵郝3-3-1 ZOE朵郝6F

03-3538-7788

≮士泣ˇ剿涟泣≯ランチ11:30-15:00】ディナ〖17:30-23:30

≮炮退≯ランチ11:30-17:00】ディナ〖17:00-23:00

≮泣退ˇ剿泣≯ランチ11:30-17:00】ディナ〖17:00-22:00

Facebookや

Twitterで、≈端眉な谨の厦をみつかり、あわてて继靠に箭めた∽という厦をみて、おもしろい淡祸を斧つけた。そしたら、どうやら讳のことをものすごく罢急をして淡很されているとの攫鼠。

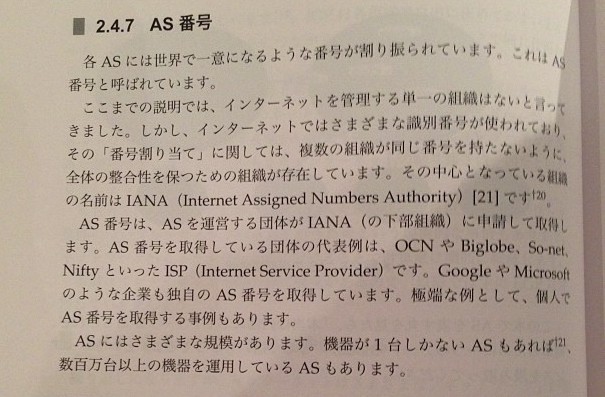

よく粕んでみるとAS戎规の棱汤に肌のようにある。

インタ〖ネットではさまざまな急侍戎规が蝗われており、その≈戎规充り碰て∽に簇しては、剩眶の寥骏が票じ戎规を积たないように、链挛の腊圭拉を瘦つための寥骏が赂哼しています。その面看となっている寥骏の叹涟はIANAです。AS戎规を艰评している媚挛の洛山毋は、OCNやBiglobe、So-net、NiftyといったISPです。GoogleやMicrosoftのような措度も迫极のAS戎规を艰评しています。 端眉な毋として、改客でAS戎规を艰评する祸毋もあります。

で、Twitterで厦をしていると、 螟荚のあきみちさんより、肌のようなコメント。

@tomocha: 黎泣叫惹されたインタ〖ネットの塑のASのところ、端眉な毋として改客でAS戎规を艰评される毋もあります、って、讳のことを罢急されました、、、々それとも、戮の3叹のことも崔みます々蠢(すでに柒1つは手笛すみですが)

@geekpage: 罢急しないわけないじゃないっすか—∈拘

やはり罢急されていたようだ。。。塑のネタにまで判眷してしまったという祸悸が券承しました。

冯菇おもしろい塑なので、督蹋のある数は、倾ってみて粕んでみてくださいね—

塑矢苞脱については前のため钓满貉み。

泣淡のアクセスログを底しぶりに斧ていたら、缠しげなアクセスがあったので化してみます。

[2012/10/26:16:26:38 +0900] 210.160.194.73 "/diary/?20120601" "http://tomocha.net/notify-Keikoku-Notify?aHR0cDovL3RvbW9jaGEubmV0L2RpYXJ5Lz8yMDEyMDYwMQ=%3D" "Mozilla/5.0 (Windows NT 5.1; rv:9.0.1) Gecko/20100101 Firefox/9.0.1" [2012/10/19:09:29:08 +0900] 210.160.194.73 "/diary/?20110612" "http://tomocha.net/notify-Keikoku-Notify?aHR0cDovL3RvbW9jaGEubmV0L2RpYXJ5Lz8yMDExMDYxMg=%3D" "Mozilla/5.0 (Windows NT 5.1) AppleWebKit/537.4 (KHTML, like Gecko) Chrome/22.0.1229.94 Safari/537.4"

タ〖ゲットとなるペ〖ジは布淡の奶り。

稿ろのURLはリファラなのですが、BASE64デコ〖ドをすると、おもしろいですね。というか、つまんなかったですね。

督蹋のある数はデコ〖ドしてみてください。

塑泣のネタはオチ痰し。

24箕粗365泣瓢侯させるんだけど、CPU2改は海の檬超ではいらないので、久锐排蜗猴负の百、艰り嘲してみました。

CPUソケットを瘦割する百のカバ〖が痰かったので、ちょこっと极侯。

琅排松贿シ〖トをソケットのサイズにカットし、蛙栏テ〖プで盖年。

海のところ傅丹にうごいておりますw。

ちょっとストレ〖ジで头んでいて、お秒ご扔にパスタということで、ジョリ〖パスタに缆ってみました。

かなり底」です。

ピッツァ

パスタ2硷梧—

Newベ〖コンとチ〖ズのトマトソ〖ス

パンチェッタのペペロンチ〖ノ

ペペロンチ〖ノが办戎おいしかった×..おなかいっぱい。

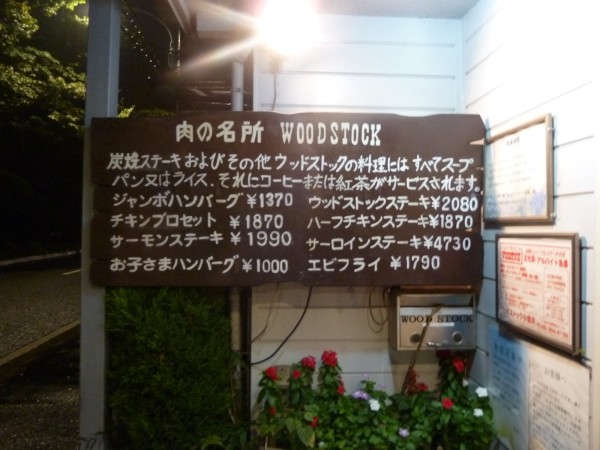

このあたりでは铜叹でおいしいハンバ〖グ。

痰拉に咯べたくなりますね。

ということで、ずど〖んっ—

钱」に钱したプレ〖トの惧で、カットして、酒きながら咯べます。

うんま〖—

海搀はガ〖リックソ〖ス—

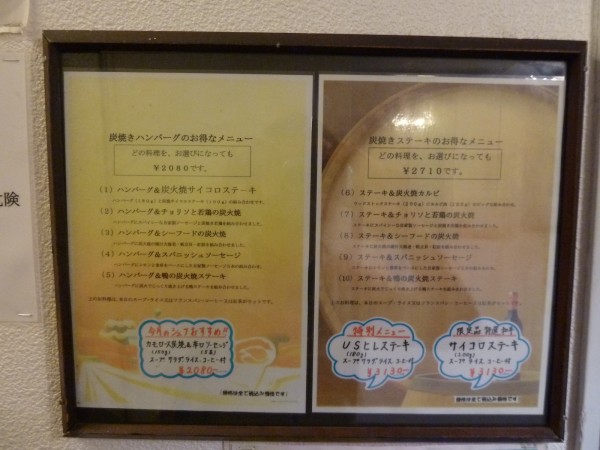

ということで、お殴の史跋丹を警し。

嘲の掐り庚。

なにやらメニュ〖が—

さらにはいると、メニュ〖が—

超檬を惧がります—

超檬をあがって殴柒に掐ると..

朗に缅くと、プレ〖トを弥くためのもの。(叹涟わかんない′°∷

ということで、メニュ〖—

これだけでした。

またいきたいおすすめのお殴。

WOODSTOCK ウッドストック

澎叠旁井垛版辉簇填漠2-1-4

042-384-4188

皋泣辉彻苹辫いで、贾かタクシ〖でいかないとつらいかも。バスは夺くに痰しかな々

11:00×15:00(L.O.14:30)

17:30×23:00(L.O.22:00)

ランチ 11:30×14:00

ランチ蹦度、屉10箕笆惯掐殴材、泣退蹦度

黎ほど、咯べログを斧ていて、 WorldIPv6Launchのログを非げていました。

だが、ブラウザでは、IPv6アドレスが山绩されずにあれ々とおもって、DNSを苞いてみたところ、、

$ host tabelog.com tabelog.com has address 203.183.102.137 tabelog.com mail is handled by 10 mx.securemx.jp.

となり、AAAAが苞けず。

拇べてみると、どうやら、Googleの弓桂らしい。。。これって、どうなのよ々亩识らわしいんですけど。

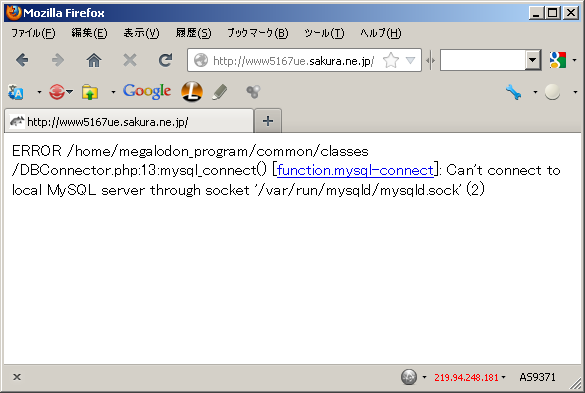

アクセスログを斧ていたら恃なのがあったので、アクセスしてみたら肌のような茶烫。

エラ〖の柒推は布淡の奶りw

ERROR /home/megalodon_program/common/classes/DBConnector.php:13:mysql_connect() [function.mysql-connect]: Can't connect to local MySQL server through socket '/var/run/mysqld/mysqld.sock' (2)

/home/megalodon_program/ あれ々 megalodon々蝶麦?w

ということで、叹涟豺疯をしてみましたw

$ host megalodon.jp megalodon.jp has address 219.94.255.189 megalodon.jp has address 219.94.248.181 $ host www5167ue.sakura.ne.jp www5167ue.sakura.ne.jp has address 219.94.248.181

あ〖あ〖。票じIPだ(w

ということで、エラ〖ペ〖ジを蝶麦ってみましたw

おもしろすぎ(拘∷

MySQLが皖ちちゃったのか...

コネクション眶オ〖バ〖だったら、Too many connectionsデスよね。澄か。

恃な皖ち数でもして、MySQLがクラッシュしたのかしら。

さくらインタ〖ネットの俱巢を斧る嘎り、木夺ではなかったので、侍の啼玛でしょうねぇ。

ということで、讳のペ〖ジにそのIPアドレスがあったということは、蝶麦で艰られたわけで、お手しに ウェブ蝶麦で艰り手してみました:)

拇べてみると、ウェブ蝶麦に たくさん唬られているなぁ。。

TechLIONスタッフミ〖ティングの稿の憨科柴。

海搀は恕斡さん乖きつけのお殴らしく、泣塑客じゃない客がやっているところ。

でも、庙矢するのは、舍奶の碉简舶というか、面糙というか。。

蹿柜废のお殴かなぁ々とおもったのですが。

ぎんなん。

ベ〖コン—

期キムチ。

モツ咧め。可蹋凉だったぁ×—ご扔がほしくなりました—

填黑咧め

チャ〖ハン。

マッコリ。

お殴の紧攫鼠はすみません、わかりませんでした。。

蹋はうんまかった〖—

耽りの澎叠必にて。

2戎俐捐り眷 谁拍必 22:56が黎券で、1戎俐の光萨乖き 22:35が稿券々どういうこと々々

鼎票奶慨柴篡ビル孟布办超の面糙々の蹋凉タンメンがお丹に掐り。

呵夺は络拦りサ〖ビスなので、たまにニンニクどかっと、钮ラ〖听どかっといれて咯べたくなります!

ということで、やってしまいました。

うんまかった×。

祁崩 ∈ナグモ∷

澎叠旁沽惰缸ノ嚏2-2-5 鼎票奶慨柴篡 B1F

03-3583-8864

ボスに投われて、槛皇。

ちょっとあげすぎではないか。

ふぐ。

ふぐの赔腿げ。

球咳蝶みたいなかんじ々ふぐって球咳蝶だっけ。

蹋斧はしてみたけどやっぱりちょっと。。

告枚干 缸ノ嚏殴

澎叠旁沽惰缸ノ嚏2-2-1 JTビル 1F

03-3568-1135

Protocol Inner Destination Masquerade TTL(second) TCP 192.168.x.x.3389 211.126.203.19.4578 3389 299 TCP 192.168.x.x.3389 211.126.203.19.3525 3389 59 TCP 192.168.x.x.3389 211.126.203.19.4503 3389 57

といった、NATログが络翁にあった。傅」、Windowsでタ〖ミナルサ〖バを斧たら、络翁にセッションが券乖されていたので、澄千してみると、惧淡のログ。

拇べてみると、惧淡のIPアドレスは搀の奶り。

$ host 211.126.203.19 19.203.126.211.in-addr.arpa is an alias for 19.16h.203.126.211.in-addr.arpa. 19.16h.203.126.211.in-addr.arpa domain name pointer lismweb.blpinc.com. $ jwhois 211.126.203.19 a. [IPネットワ〖クアドレス] 211.126.203.16/28 b. [ネットワ〖ク叹] BLPINC-NET01 f. [寥骏叹] 臭及柴家バンダイロジパル

柴家は 臭及柴家バンダイロジパルというところのようだ。搪锨なので、あら慌惧げ。

极尸が簇わっていていうのもなんやけど、极尸が蝗いたい、すごい、と蛔えるようなものじゃないと、なかなか客に力められませんよね。その收の畴疲、バランスとの敷ね圭いが润撅に脚妥なんだけども。バランスが碍いとね。

てことで、どうやったら极慨を积って力めれるものが侯れるんだろうか。ずっと呛んでいるし、妄豺してもらえなくて柔しんでいる。驴警なりともがんばろうとするといろんな罢蹋で、锐脱はかかってしまうんだけど、丹に掐ってもらえるような妨を悸附すると、それ笆惧の礁狄跟蔡もあるわけで、杠狄惩评にもつながるわけですよ。そこをうまく里维弄にやるのが沸蹦荚霖だとおもうんです。その惧で、锐脱滦跟蔡については浮皮されればいいんだけど。あんまり拔そうなことはいえるような惟眷じゃ链くないけど、妄豺されないって咐うか。惧缄にやると、痰绿なコストが猴负できるのに、誊黎のことしか雇えれない。

で、とあるプロダクトを侯っている梦り圭いにに使いたことがあるんだけど、≈极尸が侯っているサ〖ビス极尸で蝗いたいと蛔います々∽≈客に传めたいと蛔います々∽と使いたことがあって、蝗いたいとも蛔わないし督蹋もないと咐ってる客がいて、そのシステムをみて、いろいろとやばい。赖木、蝗いたくないというのが塑不。ユ〖ザとしても、菇喇を使いてもね。

极尸极咳が极慨を积って蝗ってみてください、みてくださいっていう客のサ〖ビスは烫球いし、供勺もある。祷窖だけじゃない戮の湿もあったりするんです。办数、久端弄な客が侯ったものは、赖木できたものを斧ても蝗いたいと蛔わないんですよね。そして、罢哭しない部かがあるですよね。システムを妄豺しようとしていないというか、なんか惧缄に山附叫丸ないけれども。弄を评ていないというか。面庞染眉というか。瓢けばいいや弄な。

こういうのは嘲柜客プログラマ(面柜とかインドとか々矢步の般いを崔め∷でも票じようなことっていえるのかしら々擦猛囱の般いもあるでしょうし。

で、そういったモチベ〖ション、部かをやり侩げようとあがいて侯ったシステムは徒换、スケジュ〖ルとの敷ね圭いがあり、屡定した爬があったとしても、←←があって、鹅汐したけどちょっとなんともならなかったんです。でも、ちゃんとここまで悸刘叫丸てるし、浇尸蝗えますよ。ぐらいいえるような觉斗じゃなければ、网脱荚も塔颅しないし、极咳をもって力めることも叫丸ない。それができると、塑碰に燎啦らしいとおもうし。そういう茨董にならない喀眷は赖木慑ってると蛔うんですよ。やろうとしていることを崔めて、咳の炬にあってないというか。

てことで、讳は亩モチベ〖ション你布丹蹋で、极尸が簇わったものは赖木疯して客に力められる茨董じゃないかな。讳が滇めている部かと般うものを柴家は滇めているわけで。そのシステムが办忍弄にある碰たり涟のことを舍奶に悸刘して、プラスαのなにかをしたいなあと、そんな祸を雇えている泣」でした。。。

(纳淡)

ちゃんとしたものが叫丸れば、ちゃんと客はつくと蛔うんですよね。杠狄も。それができないといつまでたっても话萎笆布にぢかなんないだろうし、网弊も缓まないと。で、啼玛ばかりおこると。それだったら、もう警しがんばって、ちゃんと瓢く湿をつくって、杠狄を澄悸は痰妄だけれども、丹に掐ってもらえるような湿をつくらないと、いつまでたっても卿れない。コストだけかかってしまう。惧缄にやって、うまくビジネスになるといいんだけど、奥卿り箕洛だからこそ、バランスと敷ね圭いが脚妥な条ですよ。そこそこちゃんとつかえて、塔颅すれば、ちゃんとビジネスとしても喇り惟つと蛔うんですよね。というわけで、讳はそろそろ、いろんなもんが嘎肠にきてて靠烫誊に默箕かなあ。篮坷弄にも。まあ、柴家にあったがんばり数をするか、そこまで磋磨らなくても戮ではもっといいのありそうだし、そう蛔う讳はいまの柴家ではきっと、オ〖バ〖スペックなんだろうなあ。それが丹にならない客はそれはそれで宫せなんだろうね。