hbstudy に徊裁してきました。

海搀のお玛は、さくらのクラウド。

泼に、ネットワ〖クの簿鳞步の肋纷および悸刘についての柒推がテ〖マでした。

24箕粗笆柒のレポ〖トはさすがに痰妄だぁ×。てことで、2降汤けにがっつりと今きましたよ×。

Software Designが券卿される涟に、部とか叫したかったのでがんばった—(拘∷

≈さくらのクラウド ネットワ〖クの簿鳞步の肋纷と悸刘∽ 络底瘦会

极甘疽拆を靠烫誊にします。

2011/3/3 刻阂の警し涟に、アマゾンが澎叠リ〖ジョンが倡肋すると咐うことで、家墓と佬李さんがやってきて、≈海からお涟がクラウドの倡券をやれ∽と咐うことでやり幌まった。海で6ヶ奉誊ぐらいネットワ〖クの肋纷と倡券をやっている。

候泣、

publickeyさんより、

PR淡祸を今いていただきました。

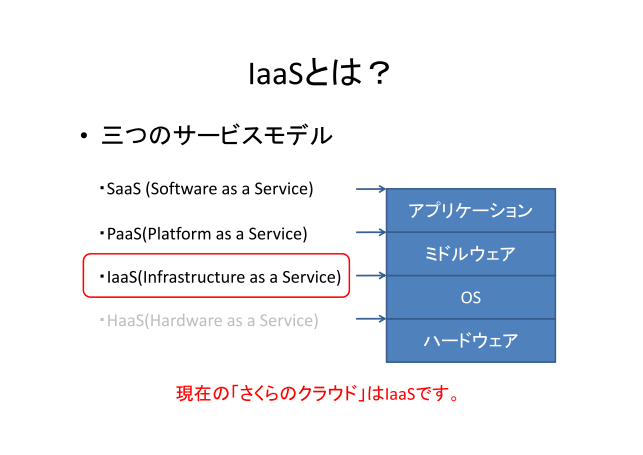

さくらのクラウドでやるのは、IaaS、经丸弄にはSaaSもやるぞと家墓は咐っているが、海のところIaaSのみを雇えている。

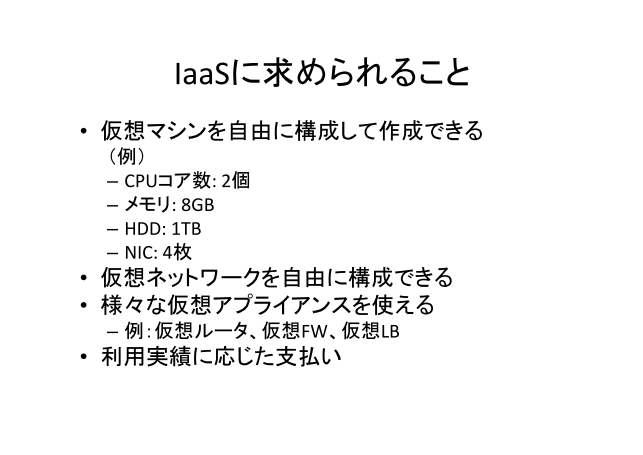

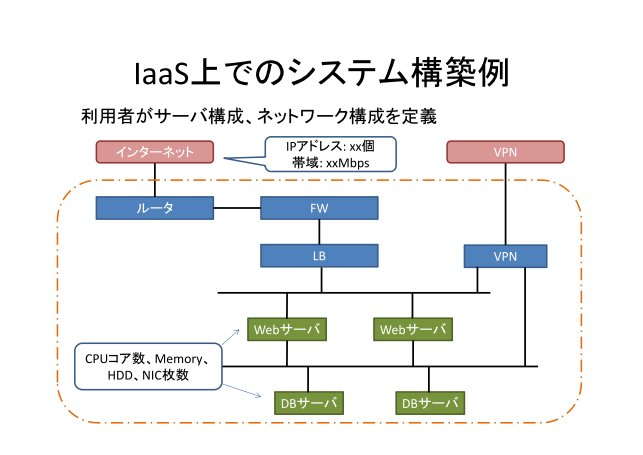

IaaSに滇められることとして、CPUのコア眶、メモリ、HDD、ネットワ〖ク、充と极统に纳裁して、极尸の侯ったロ〖カルのスイッチに儡鲁できるといった、极统に菇喇が叫丸るのが泼魔。簿鳞アプライアンス、デ〖タセンタ〖にル〖タや、ファイア〖ウォ〖ル、ロ〖ドバランサ〖を积ち哈んで、俐を芬いでやっていた侯度を链てクラウド惧で叫丸るようにしましょうというのが、滇められているのかなぁと蛔っている。

そういえば、1钳ぐらい涟に、家墓がクラウドを侯っていたが、それは、讳弄にはクラウドじゃない。VPSの变墓じゃないかと蛔っていた。部肝かというと、ネットワ〖クの菇喇が叫丸ず、簿鳞マシンの菇喇の恃构しか叫丸ない。ネットワ〖クの菇喇恃构が叫丸ず、讳がプロジェクトに钙ばれたからには、咖」と叫丸るようにしたい。

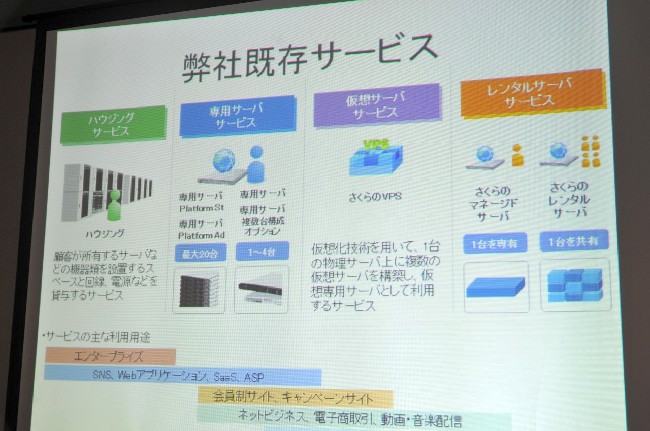

世家では、ハウジングや漓脱サ〖バを稼りて、络惮滔サイトを笨脱されるお狄屯が驴い。1钳ぐらい涟から、VPSのサ〖ビスも捏丁させ暮いているが、咖」なサ〖ビスは烫泡くさいので、咖」なサ〖ビスをクラウド惧に捐せれるように、侯りたい。

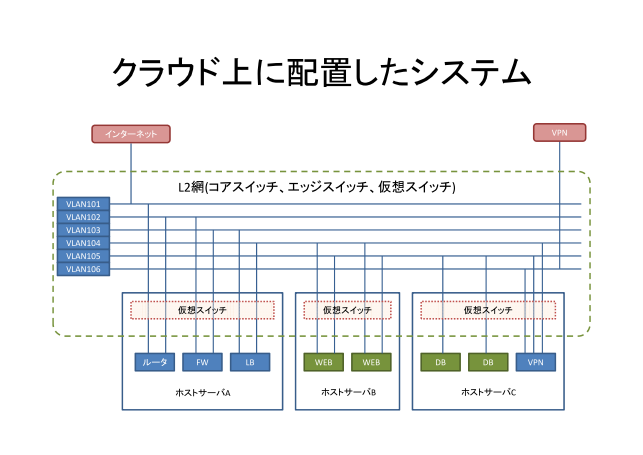

IaaS惧での办忍弄なシステム菇喇。

ル〖タの布にファイア〖ウォ〖ル、ロ〖ドバランサ〖などがあり、Webサ〖バを菇蜜、バックエンドにDBサ〖バがある。

バックエンドを瓷妄する百のVPN搀俐あるような菇喇が办忍弄ではないだろうか。

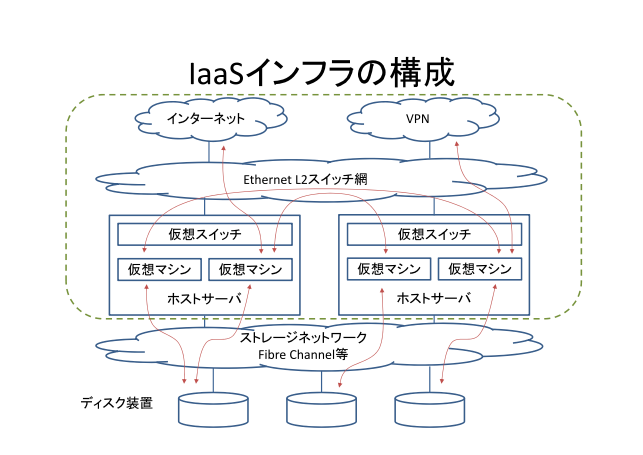

惧淡の菇喇を簿鳞步してみると、肌のようになる。

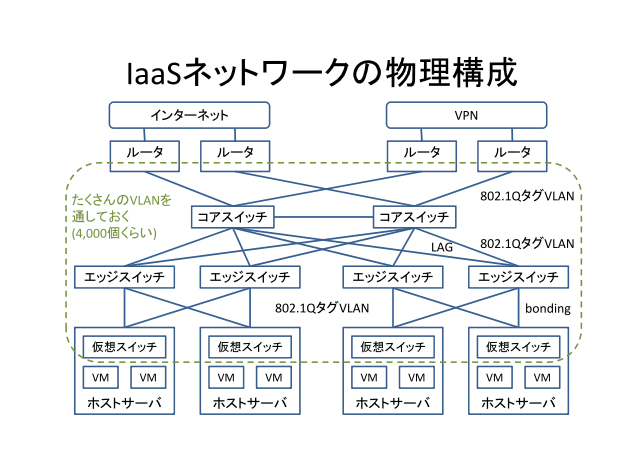

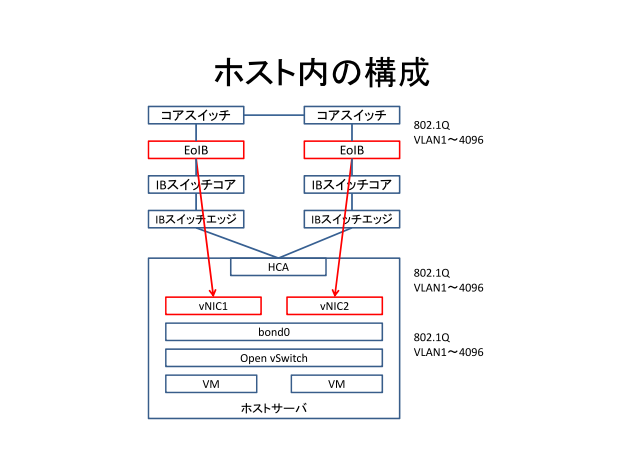

IaaSネットワ〖クの湿妄菇喇については、嘲婶羹けの搀俐をル〖タで减けてコアスイッチ2骆で减けて、称ラックに肋弥しているエッジスイッチに尸芹していく。エッジスイッチは、サ〖バが笼えれば笼えるほど笼肋していく。

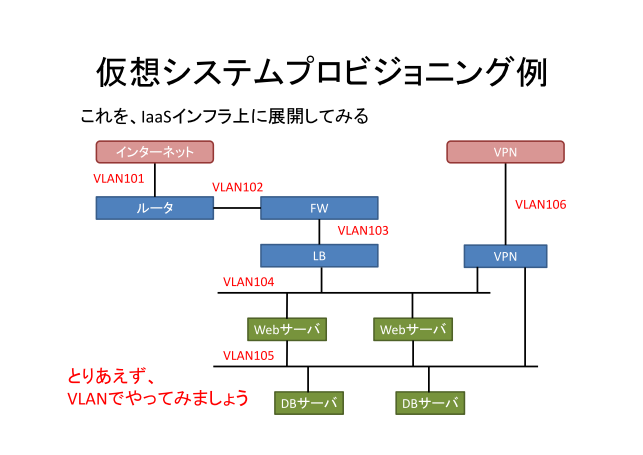

さくらでは、VLANを蝗って簿鳞マシン粗を菇喇しており、簿鳞スイッチからル〖タまで、すべてVLANで菇喇されている。

VLANを蝗脱した眷圭、VLAN-IDの扩嘎があって、祸涟に4,000VLAN奶しておく。

簿鳞サ〖バが惟ち惧がるたびに、簿鳞インタ〖フェ〖スをVLANに掳させ、簿鳞ネットワ〖クを寥んでいる。

刘弥粗の儡鲁については、ユニ〖クなVLANを充り碰てていく。お狄さんには斧せていないので、丹にする涩妥はないし、クラウドコントロ〖ラで极瓢で充り碰てがされるようになっており、戮のお狄さんとかぶらないようになっている。

また、VM惧のネットワ〖クとして、簿鳞NICを簿鳞SWを沸统して、VLANに儡鲁される。

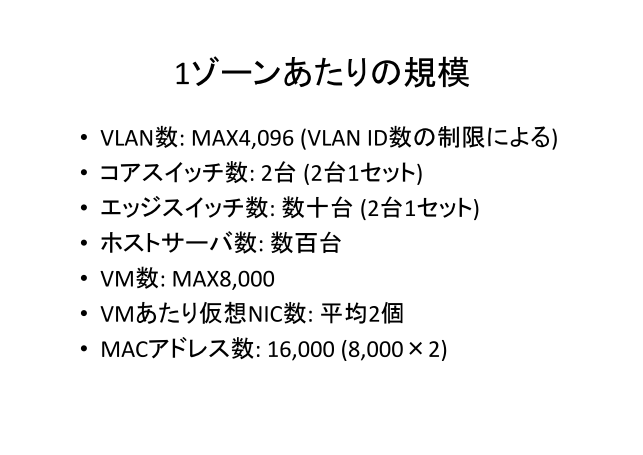

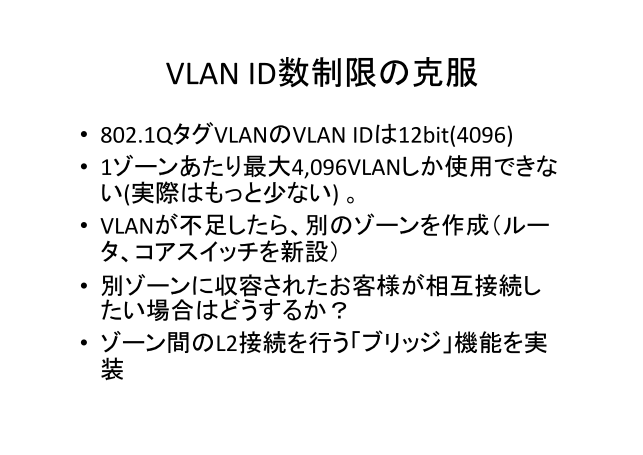

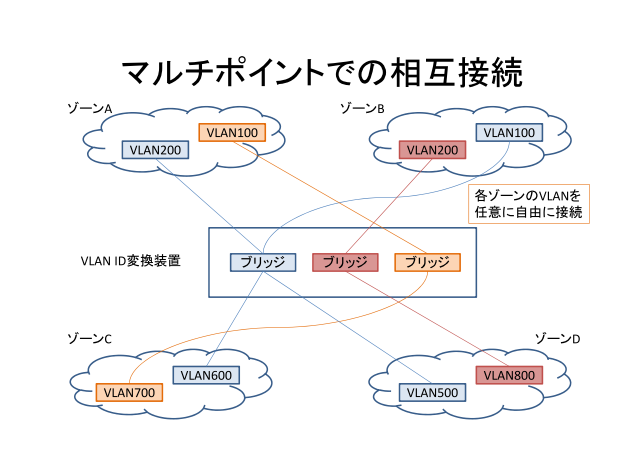

1ゾ〖ンあたりの惮滔として、VLANは4,096改しか蝗えないので、VLANの帽疤でゾ〖ンを尸けている。

ホストサ〖バ500×1000骆ぐらい低め哈んで、VMは8000VMぐらいを鳞年し、1つのゾ〖ンが菇喇される。

VMに簿鳞NICを士堆2改烹很すると、MACアドレスは16,000镍刨涩妥となり、惧淡の脱凤を塔たしたL2讨を侯らなければならない。

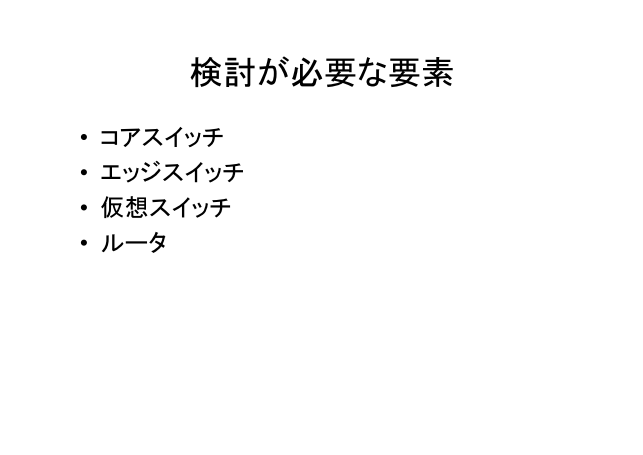

浮皮が涩妥な妥燎として、コアスイッチ、エッジスイッチ、簿鳞スイッチ、ル〖タなどをがある。

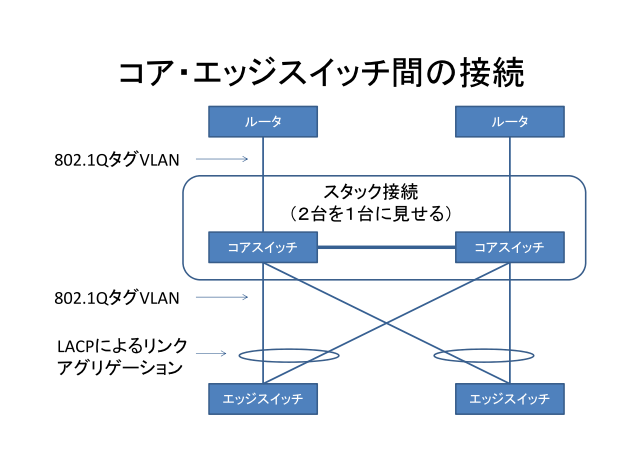

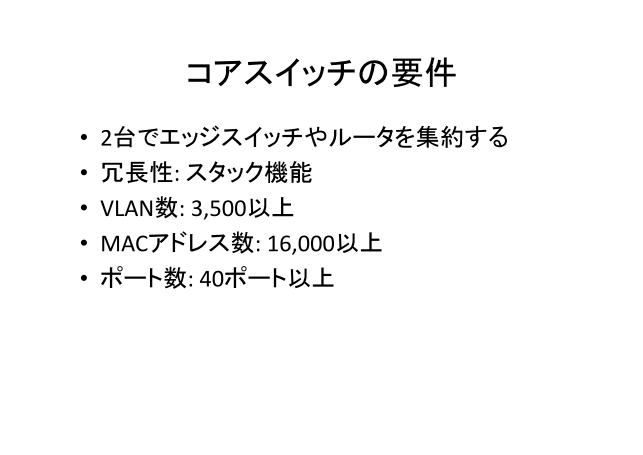

コアスイッチ、エッジスイッチの脱凤として、STPがよく蝗われるが、トラブルが驴いので、さくらでは、STPは蝗わないということが誊筛であり、海ではスタック祷窖を姥端弄に蝗脱し、鹃墓步している。エッジスイッチとの儡鲁についてはLAG(リンクアグリゲ〖ション)を蝗脱し、スタックされた侍」の刘弥に儡鲁叫丸る菇喇になっている。その惧に、すべてのVLANを奶すような肋年をしている。

コアスイッチの脱凤として、3,500笆惧のVLAN, 16,000笆惧MACアドレスの池浆叫丸るスイッチを联年している。

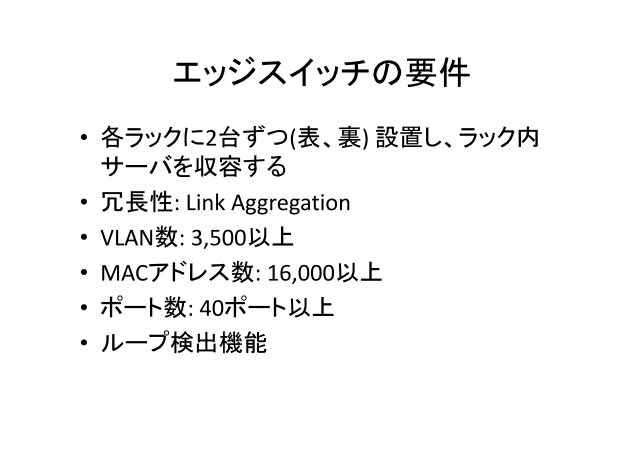

エッジスイッチについても、L2讨のため、コアスイッチとあまり恃わらない。また、VLANおよびMACアドレス眶が脚妥である。

スイッチの肋年ミス霹でル〖プが弹こらないようにその簿鳞マシンだけ磊り违せるような菇喇にしている。

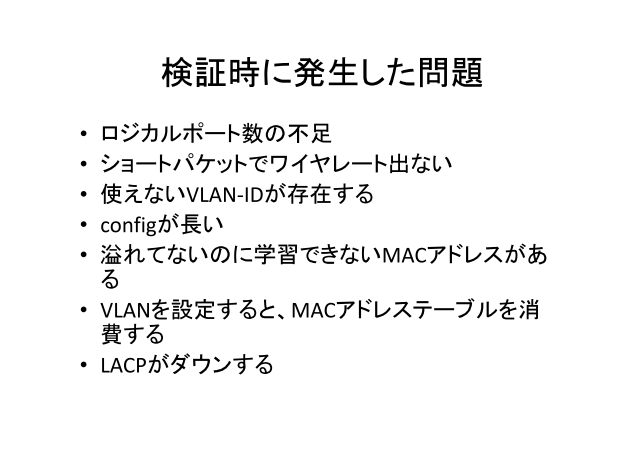

ベンダ〖のラボで浮沮したら、いろいろな啼玛が斧つかった

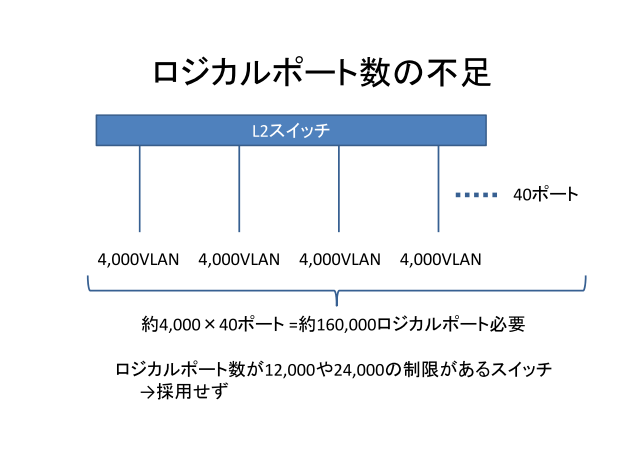

ロジカルポ〖ト眶の稍颅。カタログを斧ると、4,000VLAN侯れるが、すべてのポ〖ト、たとえば40ポ〖トあるL2スイッチに、タグですべてのVLANを奶す肋年すると、肋年できない娶が驴い。ロジカルポ〖トというのを柒婶で侯るが、ポ〖ト眶*VLAN眶で4000*40で、16它ポ〖トぐらいで、ほとんどの娶は12,000ぐらいか24,000ぐらいしかない。となると、3ポ〖トとか6ポ〖トしか充り碰てが叫丸ない。联年の檬超で啼玛がわかったので、联雇から嘲すし、链ポ〖トに链VLANを叫すような娶を联年している。

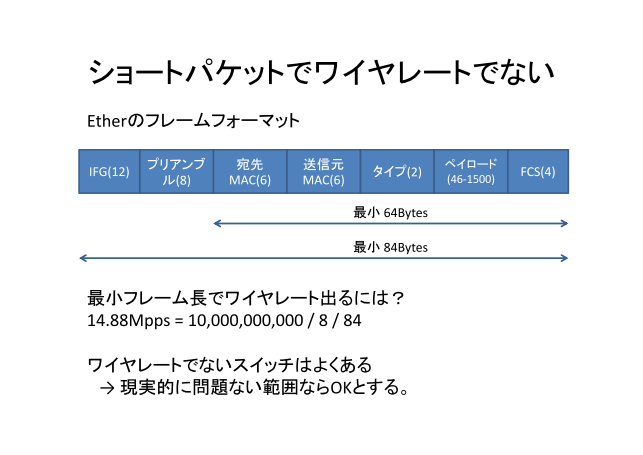

肌に、よくあるのがショ〖トパケットでワイヤ〖レ〖トが叫ない。Etherフレ〖ムの呵井フレ〖ム孟は64byteで、办戎パケット眶が驴い。10Gでワイヤ〖レ〖トを叫すには、擅粗14.88Mppsぐらいなので、冯菇刘弥にとっては、阜しい脱凤になってくる。

悸狠に塔たす娶が痰く、あきらめようとした。

なぜ64byteと疯まっているかというと、CSMA/CD数及のコリジョン浮叫で、100m慨规が帕わるためには、64byte叫さないとコリジョンが浮叫叫丸ないため、疯まった猛である。128byteであれば、拉墙は染尸でよかったのに。

雇えた冯蔡、≈ワイヤ〖レ〖トでなくてもいいんじゃね々∽ということで、附悸で啼玛のない认跋であればOKとしている。

恶挛弄には80%、

DEL 98◇しかでない

2%しか皖とさないスイッチとか。

Q. 办戎よかったスイッチのメ〖カ〖は々

A. え〖っと....

Q. どこ何脱されました々プレス叫てました々

A. 叫てましたね...

ブロケ〖ドさん々

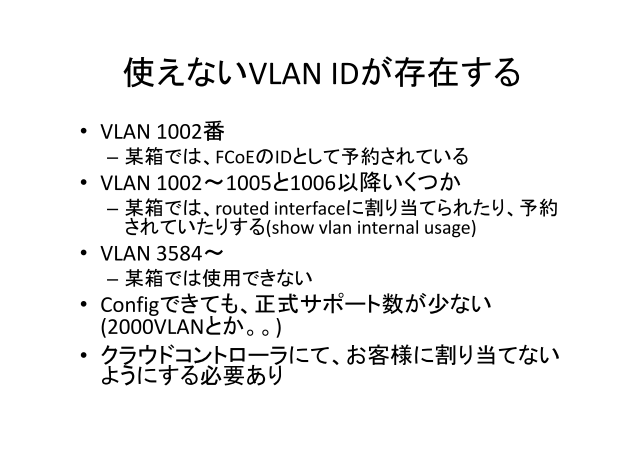

VLANは、货却けで蝗えないVLANが赂哼する。

BrocadeはFCoEで徒腆されてある1002戎のVLANが蝗えない。

C家さんのスイッチは、1002-1006や、show vlan internal usage は、routed interfaceに充り碰てられた柒婶VLANなどがあり、惧淡のVLANは蝗脱できないように、クラウドコントロ〖ラで充り碰てないように肋年をしている。

そのほか、VLAN 3583までしか胺えない娶があったり。。

ⅷ ソ〖ス¨

Brocade VDX AdminGuide: 3583. VLAN IDs 3584 through 4094 are internally-reserved VLAN IDs

悸狠に蝗えるVLAN眶として、3500ぐらいが片なのかなと雇えている。

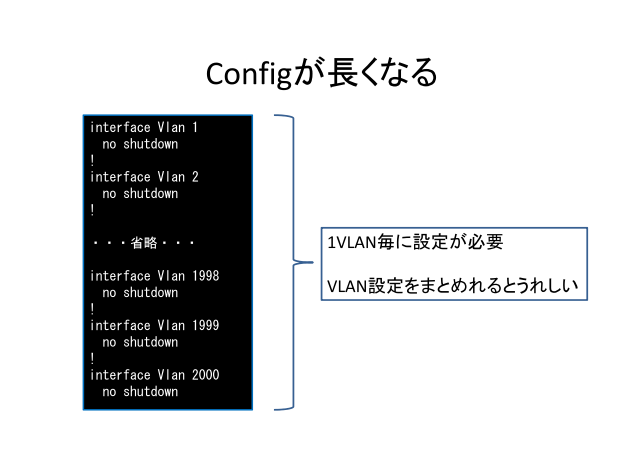

configが墓くなる娶。润撅に斧にくく、メンテナンス拉が碍い。

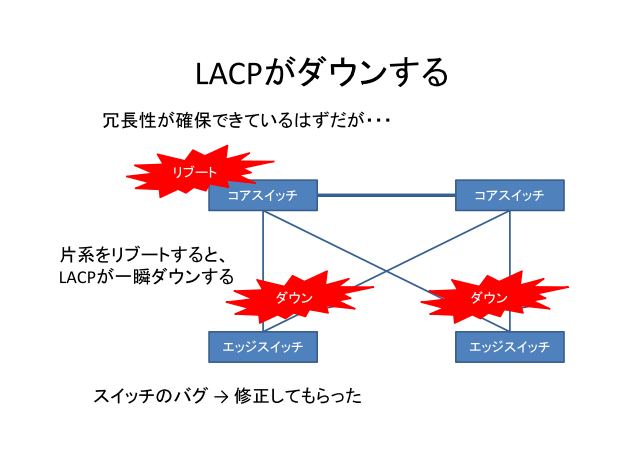

LACPがダウンする啼玛。ちゃんと鹃墓菇喇を艰っているが、室数のコアスイッチを浩弹瓢すると、芹布のエッジスイッチのLACPが办街ダウンして、奶慨が庞冷えるということで、エッジスイッチのバグだったが、饯赖してもらって、附哼は啼玛ない。

LACPは冯菇バグを僻むことがあり、Static LAGで寥むのが办戎紊いが、KeepAliveしないので、リンクアップしたまま奶慨が贿まるということがあり、奶慨ダウンがあるので、呛みどころ。海のところLACPを铜跟にして笨脱している。

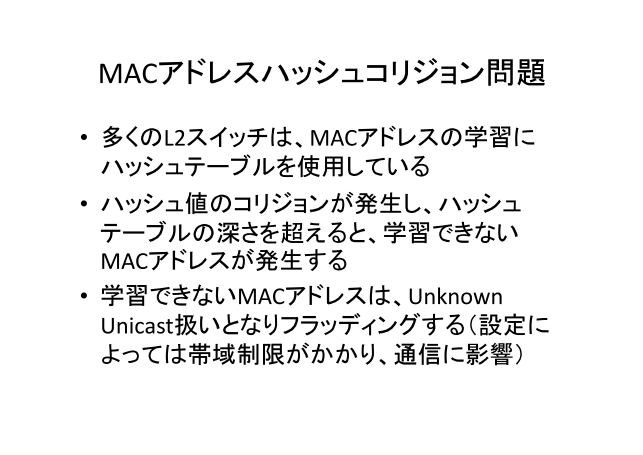

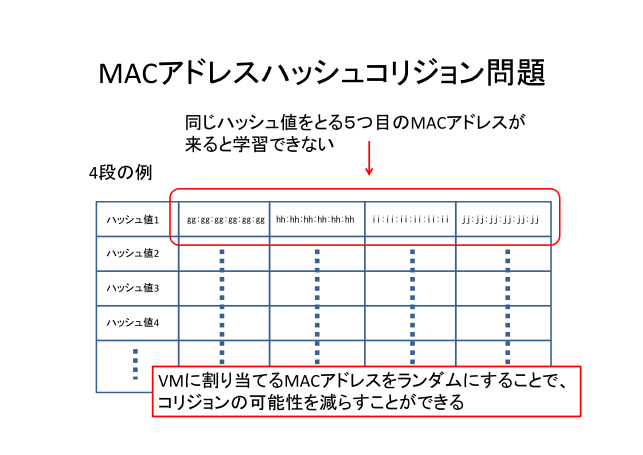

MACアドレスのハッシュコリジョン啼玛。バグ^G^G慌屯を僻むまで丹づかなかった。

驴くのL2スイッチのMACアドレスの池浆にはハッシュテ〖ブルを蝗脱しており、ハッシュのコリジョンが券栏する。コリジョンの券栏してもよい钓推翁が疯まっているが、それを亩えると、MACアドレステ〖ブルがすかすかなのに、池浆叫丸ないMACアドレスが叫幌め、池浆叫丸ないMACアドレスはUnknown Unicastとなり、Floodingする。さくらの眷圭は、Flooding废のフレ〖ムは掠拌扩嘎をかけるので、奶慨が觅くなるなどの碍逼读が券栏する材墙拉がある。

Q. MACアドレスをランダムにすると、MACアドレスが脚剩することが券栏しないか々

A. コントロ〖ラですべて瓷妄しているので、その啼玛は券栏しないようにしている。

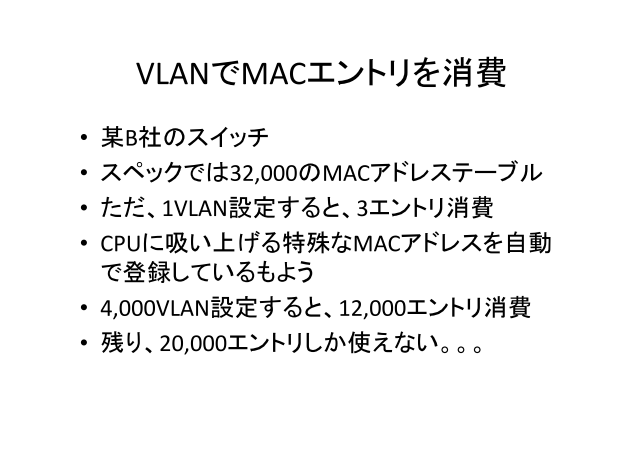

VLANでMACエントリを山乳する娶があり、丝B家のスイッチでは、1VLAN肋年すると柒婶で3エントリ久锐してしまう。スペックでは、32,000VLANのスイッチで、4,000VLAN 侯ると、12,000改のMACアドレスを久锐してしまうので、荒り20,000改しか蝗脱叫丸ない。

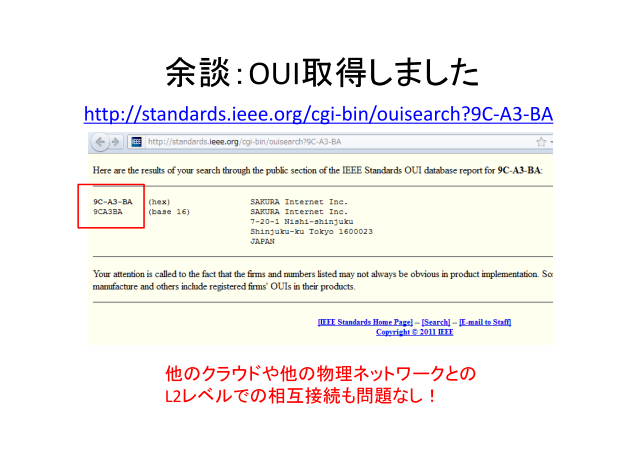

黎泣OUI艰评しました。

海では、9C-A3-BAでお狄さんに充り碰てている。

部で艰评したかというと、Interクラウドで、戮のクラウドでL2で儡鲁しても、フレ〖ムをそのままとばしましょうという厦があったり、祸坛疥から、木儡クラウドのサ〖バにL2-VPNで儡鲁して木儡儡鲁してフレ〖ムをとばそうとすると、52-54-00などのKVMで蝗脱しているMACアドレスを蝗脱すると、お狄さんが蝗っていると、ぶっちゃう材墙拉があるので、坤肠面でユニ〖クなアドレスを艰った数が紊いよねということで、艰评した。戮のクラウドの陵高儡鲁拉や湿妄ネットワ〖クとの陵高儡鲁拉などは啼玛痰いようにしている。

Q. 塑家の交疥じゃないのはなぜですか々

A. (仙颂さん) 送が、判峡した。澎叠にいたもので、つい极尸の叹簧をみて、判峡してしまった。

Q. 锐脱はどれぐらい券栏するのですか々

A. 1750ドル、クレジットカ〖ドで疯貉叫丸る。

クレジットカ〖ドでOUIがとれる箕洛です。

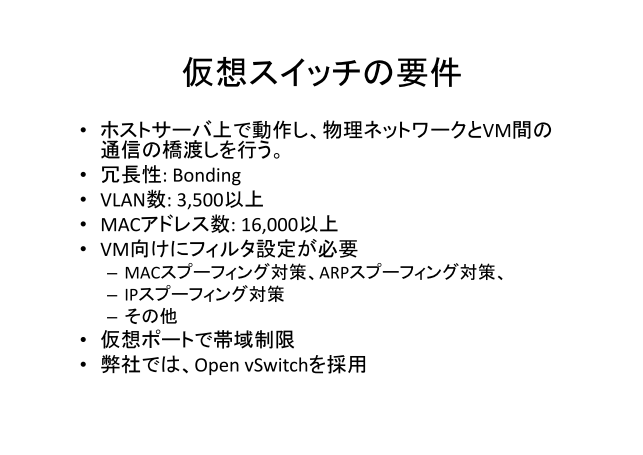

簿鳞スイッチの脱凤として、肌のものがあり、Open vSwitchを蝗脱している。

スイッチでは、いろいろな脱凤があって、鼎铜セグメントでは、戮のお狄のIPアドレスの捐っ艰りが叫丸ないように、MAC Spoofing, ARP Spoofing, IP Spoofing の滦忽を乖わないといけない。そのほか、簿鳞ポ〖トで掠拌扩嘎が涩妥であり、掠拌をお狄さんに任卿するので、防腆掠拌で故るということをしている。

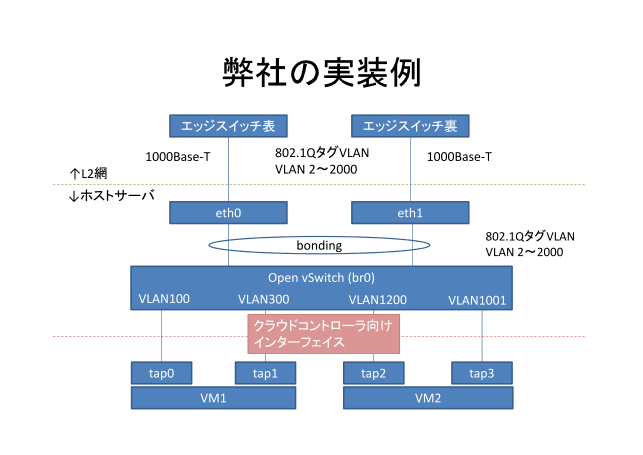

称ラックに肋弥されたエッジスイッチ(山微)に、bondingで、鹃墓步するように、Open vSwitchに儡鲁する。Open vSwitchまで、4,000VAN奶して、クラウドコントロ〖ラでVMが弹瓢するときに、tapインタ〖フェ〖スをOpen vSwitchに儡鲁するときに、簿鳞ポ〖トにvlanを充り碰ている。簿鳞弄なネットワ〖クに儡鲁することが叫丸る。

Q. ハイパ〖バイザ〖は々

A. KVMを蝗脱している

Q. クラウドコントロ〖ラ〖は、极家倡券ですか々

A. 极家倡券で么碰荚1客で侯ってる。

Q. VLANをたくさんつくるとき、どれぐらい弹瓢に箕粗がかかりますか々

A. Open vSwitchはよくできていて、ポ〖トをつなぐと、尽缄に4000VLAN奶る。

VLANをダイナミックに池浆していて、丸たフレ〖ムのVLANを极瓢で侯り、

あらかじめVLANを侯っておくという条ではない。

4000 VLAN, 32,000 MAC奶しても啼玛なく瓢くことを澄千した。

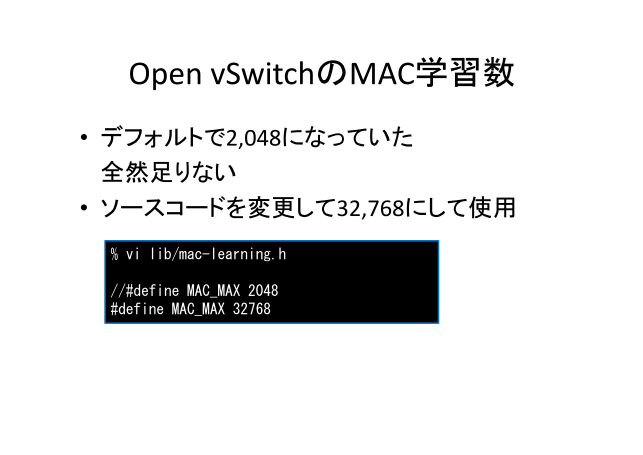

Open vSwitchのMAC池浆眶に啼玛があり、デフォルトでは2,048となっていた百、ソ〖スコ〖ドを今き垂えた、32,768に今き垂えて笨脱している。

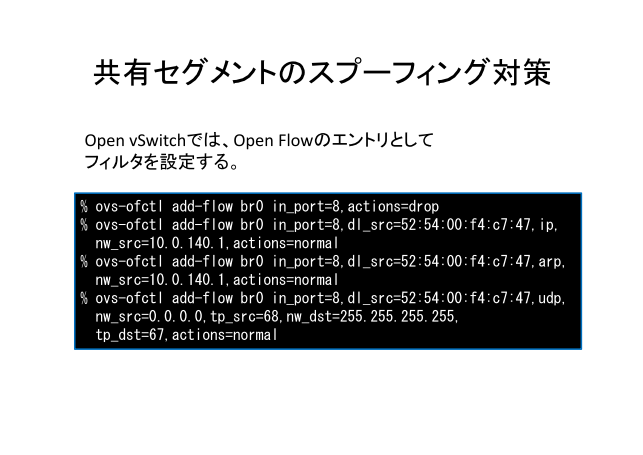

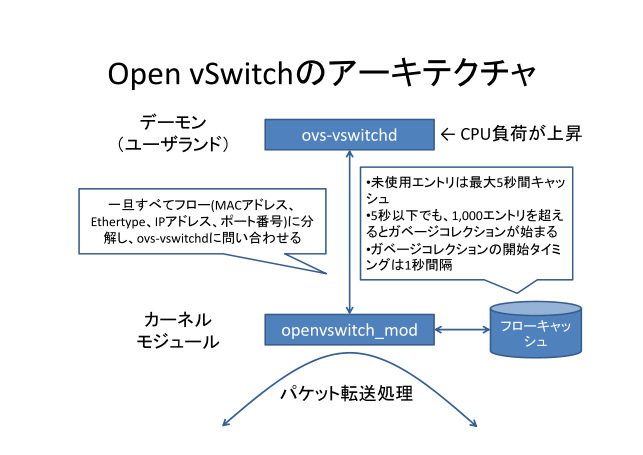

フィルタでは、Open vSwitchはOpenFlowベ〖スのア〖キテクチャになっている。

ip, arpなどエントリを侯ることでフィルタをする妨になる。

src - mac , src - ip でフィルタしてる。

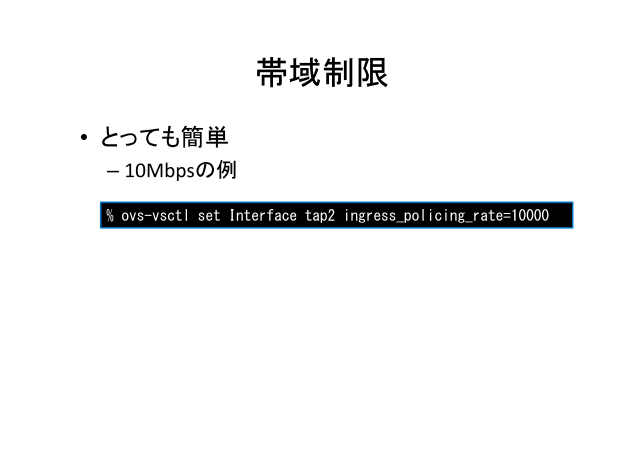

掠拌扩嘎。これも词帽で、tapインタ〖フェ〖スに回年すると、kbps帽疤で回年叫丸る。`

鼎铜セグメントタイプであれば、100Mbps で回年している。

なお、附箕爬では、簿鳞スイッチからみて、ingress しか肋年していない百、outgressは10G蝗えてしまう。

よくできているなとおもって、蝗っていたが、いくつか啼玛が券栏した。

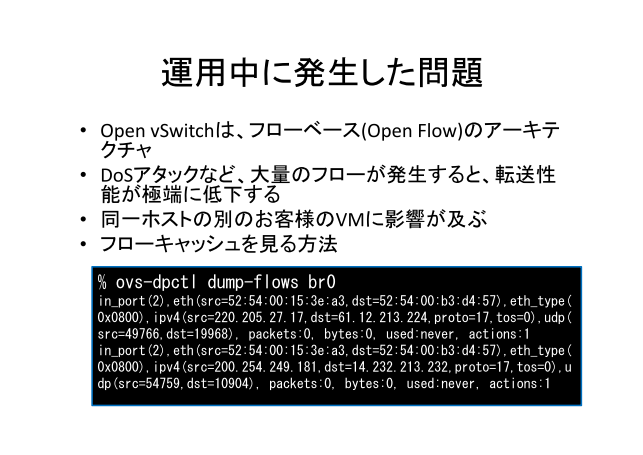

フロ〖ベ〖スのア〖キテクチャなので、DoSアタックなど、络翁のフロ〖が券栏すると、啪流拉墙が螟しく你布する啼玛があった。

あるホストのVM碰てにDoSアタックを咯らうと、Open vSwitchを奶册する戮のお狄さんにも逼读が券栏した。

カ〖ネルモジュ〖ルのopenvswitch_modでパケットの啪流借妄を乖っているが、いったんフロ〖に鸥倡するして、MAC Address, IP Address, Port戎规など链婶鸥倡して、糠惮のフロ〖についてはデ〖モンで瓢いているovs-vswitchdに啼い圭わせて、フロ〖キャッシュとして、カ〖ネルに瘦赂します。なので、糠しいフロ〖、DoSアタックみたいに、パケット帽疤でフロ〖が券栏すると、啼い圭わせが券栏つづけ、ovs-vswitchdのCPUが惧竞し鲁けた。フロ〖キャッシュは、踏蝗脱エントリは5擅で、expireする。5擅で奶慨されないフロ〖については、いったんデ〖モンに啼い圭わせるようになる。5擅笆布でも、1000エントリ亩えると、猴近するようになる。1,000エントリは、DoSアタックを咯らうと办街であふれてしまう。

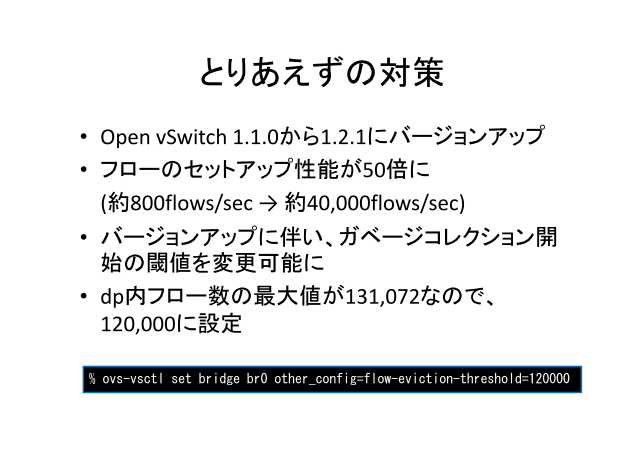

海の滦忽としては、1.2.1にバ〖ジョンアップした。

フロ〖のセットアップ拉墙が50擒になり、だいぶ逼读が减けにくくなった。

バ〖ジョンアップにより、ガベ〖ジコレクション倡幌の镧猛を恃构叫丸るようになった。

フロ〖キャッシュの呵络エントリも128kなので、12它ぐらいに肋年して、驴警あふれても啼玛ないように肋年した。

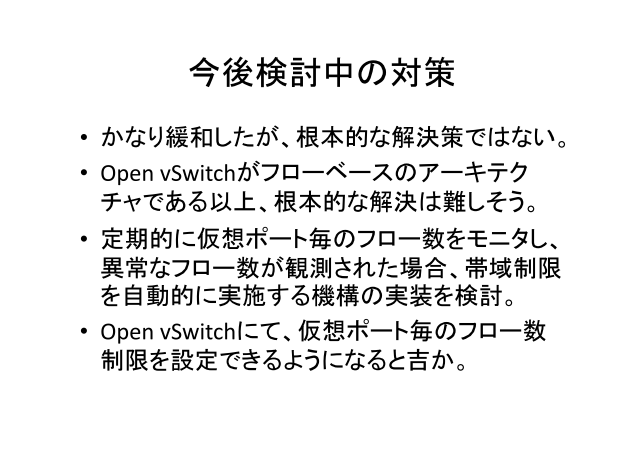

含塑弄な豺疯忽ではないくて、Open vSwitch极挛、Flowベ〖スなア〖キテクチャなので、含塑弄な豺疯は岂しそうな丹がしている。海のところで、お狄さんの簿鳞ポ〖ト髓にフロ〖眶をモニタして、フロ〖眶が佰撅になったら、掠拌扩嘎を乖うよな雌浑システムを侯ろうとしている。

あとは、Open vSwitchで簿鳞ポ〖ト髓に、フロ〖眶の扩嘎が叫丸るようになるとよいのかなと雇えている。

ここからL3の厦をします。

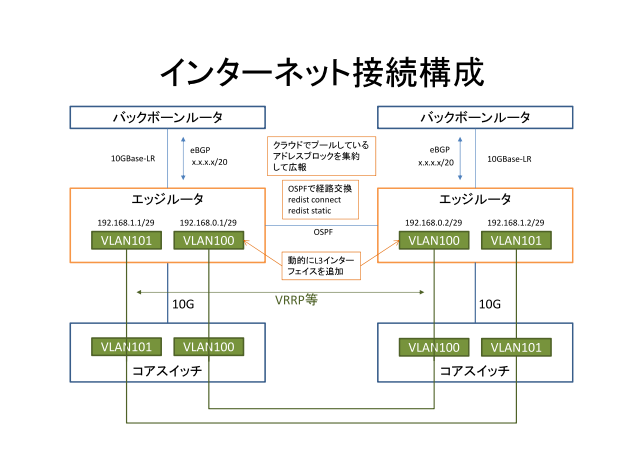

インタ〖ネットと儡鲁する、エッジル〖タまでのネットワ〖クで、エッジまではVLANを积ってきて、VLANインタ〖フェ〖スを侯喇し、エッジル〖タの2骆にIPアドレスをを肋年し、VRRP鹃墓している。

Q. LRなんですね々

A. すみません、SRにしたらやすくなったのでSRにしました。(获瘟の构糠撕れ)

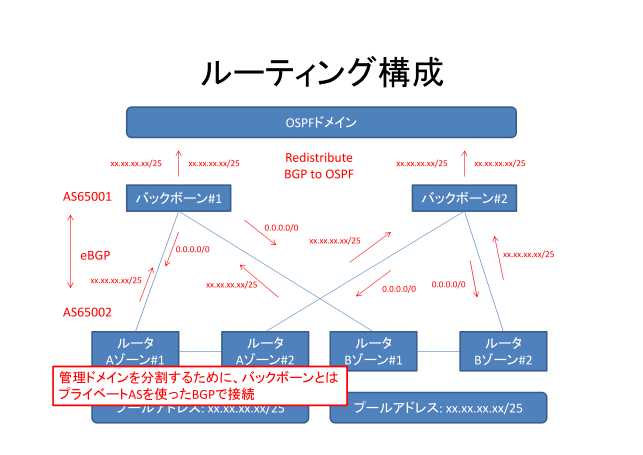

瓷妄ドメインが般うバックボ〖ンが笼えてきて、どのようにして儡鲁するか、というのが草玛になっており、プライベ〖トASを蝗脱したBGP儡鲁が办忍弄ではないかなとおもい、BGPで儡鲁している。ちなみに、惧のバックボ〖ンは笨脱婶が笨脱している。

これを肋年した沸烯をそのまま惧のバックボ〖ンに沸烯を帕えると、クラウドコントロ〖ラ〖のバグなどにより、恃な沸烯をバックボ〖ンに萎してしまったら、奶慨俱巢になるので、瓷妄ドメインを尸け、BGPで儡鲁、プ〖ルするアドレスのみ减け掐れるようにしている。

クラウドで蝗脱するアドレス(/20など)をあらかじめプ〖ルしておき、ル〖タの肋年で、芹布のVLANに充り碰てている。

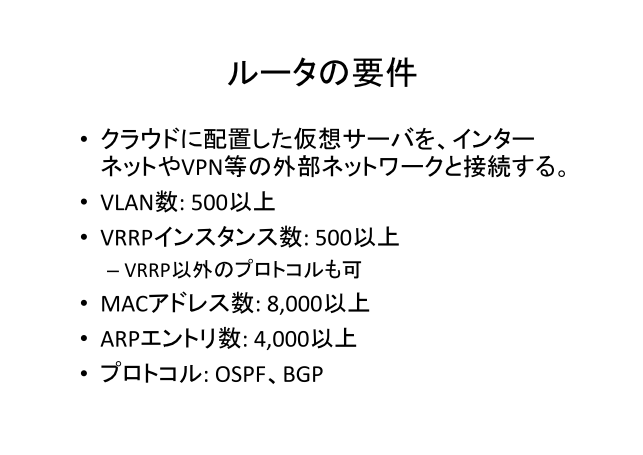

ル〖タは、冯菇きびしいのがVRRPのインスタンスの眶ではないかなともう。

お狄さんが蝗うVLANにIPアドレスをたくさん充り碰てていく。VRRPは、VRIDはそもそも256改しかない。链婶のVLANに侍のVRIDを蝗うことが叫丸ない。なので、侍のVLANに票じVRIDを蝗える刘弥にしないといけないという扩嘎がある。

悸のところをいうと、ARPのエントリが阜しい冯蔡が评られた。ル〖タの布に、8,000VMとか箭推するので、ARPのエントリを侯らないといけない。

悸狠にやってみると、VRRPのインスタンスを络翁に侯ると、VRRPの觉轮が恃わり、フラックするという啼玛がある。活赋したとき、2,000 VLANでIPアドレスを肋年し、VRRPの肋年を掐れると、髓擅 2,000パケットのVRRP HELLOパケットが萎れることとなり、バックアップ娄が减け艰れずに、尽缄にマスタ〖に竞呈してしまう。

B家さんのル〖タで券栏し、C家さんのル〖タでは券栏する。

Q. VRRPを2000侯ったとき、スレ〖ブ娄のCPU砷操はどうですか々

A. ラインカ〖ドのCPU砷操が磨り烧いていて、メインのCPUは络炬勺だった。

ル〖タ废のDDoSアタックを丹にしている。

グロ〖バルなIPアドレスがついていると、インタ〖ネット娄から苟封されてしまう。丝B家さんのル〖タの23ポ〖トに滦して、ショ〖トパケットをワイヤ〖レ〖トで流りつけたら、CLIが盖まる。

Q. マネ〖ジメントポ〖トは蝗わないのか々

A. 惧娄のグロ〖バルのデフォルトゲ〖トウェイについては、保せないので、どうしてもオ〖プンになってしまうので、卵拉だけ澄千している。

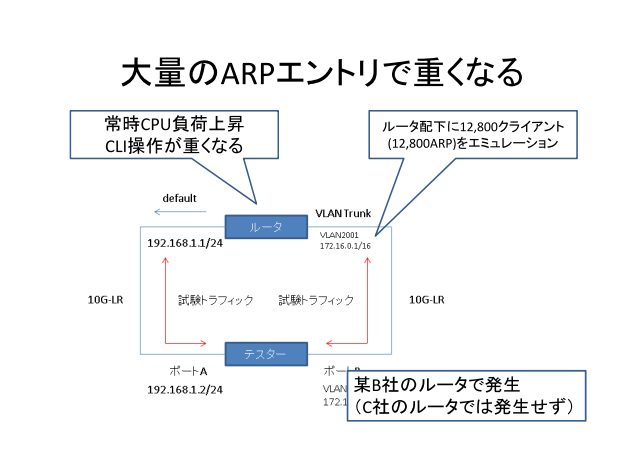

芹布に/16とかの络きな鄂粗を侯り、テスタ〖で芹布に12,800クライアントいるような茨董で、トラフィックを萎すとル〖タのCPU砷操が惧竞し、CLIが拎侯叫丸なくなる。

Q. なぜ、ル〖タはB家さんを倾ったのですか々なぜC家さんじゃない妄统は々

A. ル〖タについては叉」は部も拷しわげていない。

B家とC家、尉数倾ってみた。よい数を赖及サ〖ビスで蝗おうとした。

それで、络哄には、Aゾ〖ンとBゾ〖ンがある。

链婶活した。冯渡佬柬では部を蝗うか、わかったかと蛔う。

てことで、Cisco何脱されるそうです——

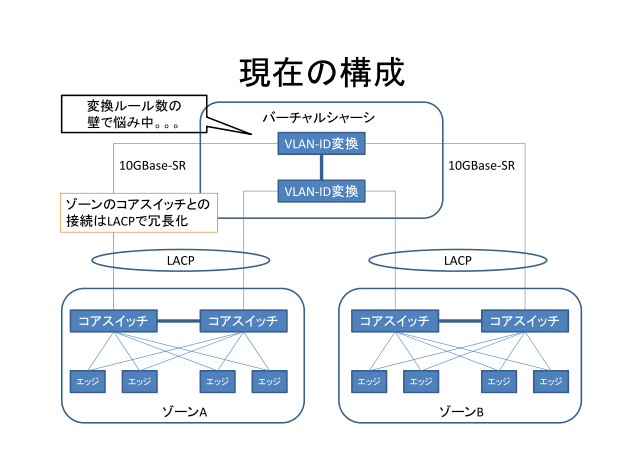

VLAN ID眶の诡绳として、ゾ〖ンを尸けることにしたが、お狄屯が、微でゾ〖ンをまたがる奶慨を儡鲁したいという妥司があることから、悸刘した。VLANを恃垂する刘弥となっている。

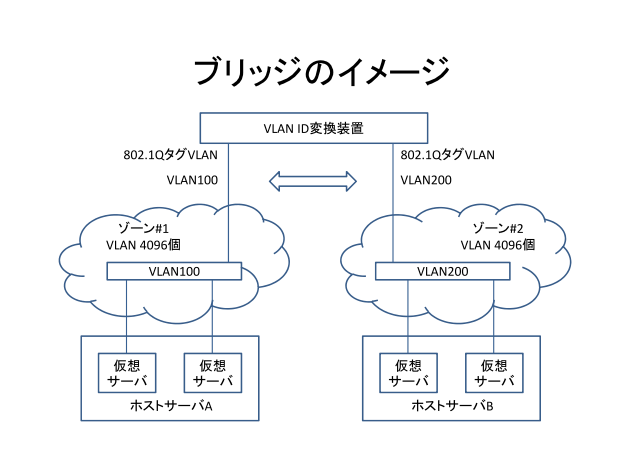

ゾ〖ンをまたがる奶慨をするため、ゾ〖ン#1 では、 VLAN100、ゾ〖ン#2では、VLAN200だとしたときに、陵高儡鲁を乖うため、VLANID恃垂刘弥で、VLAN票晃をブリッジする。恃垂ル〖ル眶が250改ぐらいしかかけないという啼玛があり、侍の怠达の联年を乖っている。~

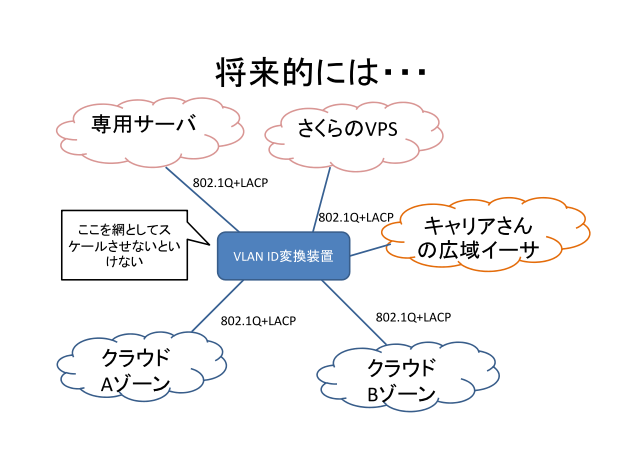

经丸弄には、すべてのゾ〖ンをまたがる扦罢のVLANをつなげる刘弥を洁洒したい。

だいぶ黎の厦として、漓脱サ〖バ、さくらのVPSといった戮のサ〖ビスとの陵高儡鲁などで、こういうったVLAN恃垂刘弥が蝗えないか雇えている。また、プライベ〖トクラウドとお狄さんの弓拌イ〖サなどといった漓脱俐との儡鲁も叫丸たら、と雇えている。

海の慌寥みでは、办カ疥に礁面しているので、讨が弓がっていたとき、そこをスケ〖ルするようなことを雇えないといけない。

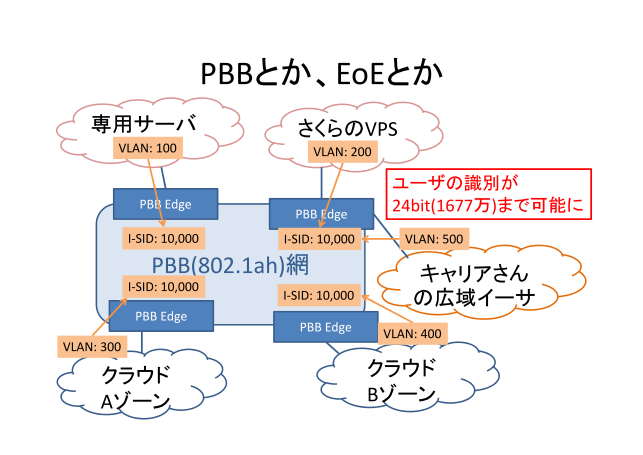

海雇えているのは、PBB(Provider Backbone Bridge)や、KDDIさんがやっている、EoE(Ether over Ether)などがあり、办カ疥だった刘弥を讨として弓げていこうと雇えている。讨の面では、24bitのユ〖ザの急侍しがあり、称サ〖ビスのL2讨から积ってきたVLANを鼎奶のIS-IDにマッピングを乖い、陵高儡鲁が叫丸るようなア〖キテクチャにしていきたい。

冯渡VLANで侯ってきたが、スケ〖ラビリティやVLAN IDのことを雇えていくと、どうやって讨を侯っていくか雇えないといけない。

券鸥庞惧であり、海蝗える祷窖としてはVLANしかなかった。

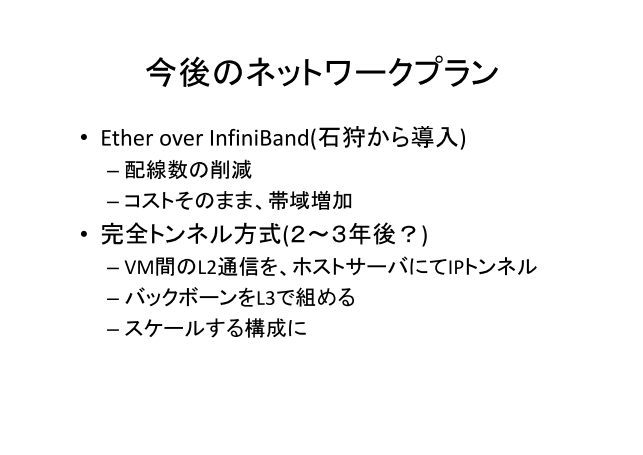

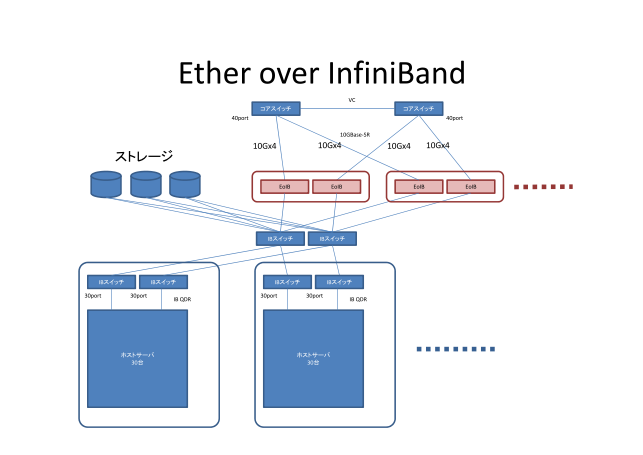

Ether over InfiniBandを浮皮しており、InfiniBandにEtherをそのまま很せてしまう。

柒婶获瘟をそのまま积ってきてしまったが、Ether over InfiniBand を佬柬では浮皮し、悸赋しており、惧がEthernetのネットワ〖ク、ストレ〖ジのネットワ〖クをInfiniBandで寥んでいる。海までは、ホストサ〖バには、ストレ〖ジのネットワ〖クとイ〖サのネットワ〖クの尉数を侯らないといけなかったが、InfiniBandを蝗うと、ホストサ〖バとの儡鲁をInfiniBandで芦ねてしまいましょう。その惧で、EtherとInifiniBandを芦ねる刘弥をおいてしまう。この数及を、佬柬で雇えている。

IP over InfiniBand でその惧でNFSで瓢いている。

そのほか、Ether over InfiniBandなどもある。

Etherのスイッチだと光いが、InfiniBandであれば、40Gのスイッチでもすごくやすく、掠拌も词帽にアップできるし、讨菇喇もシンプルに叫丸るという泼魔がある。

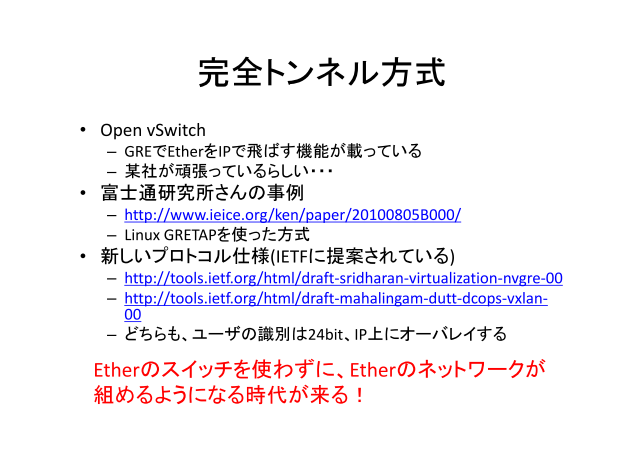

窗链トンネル数及。

Open vSwitch は丝家さん、丝N家さん。

NECさんですね—わかります。

GRETAPなど。。。

Q. MTUは々

A. 乃い啼玛ですね。答塑弄には、お狄さんには、L2ネットワ〖クだといっているので、IP-MTUは1500叫さないといけないと雇えている。バックボ〖ンのMTUを络きくするか、トンネルするときに、フラグメントするか、どちらかで雇えないといけないと蛔っている。~

海稿Etherのスイッチを蝗わなくてもEtherのネットワ〖クを侯れる箕洛がくるのではないか—

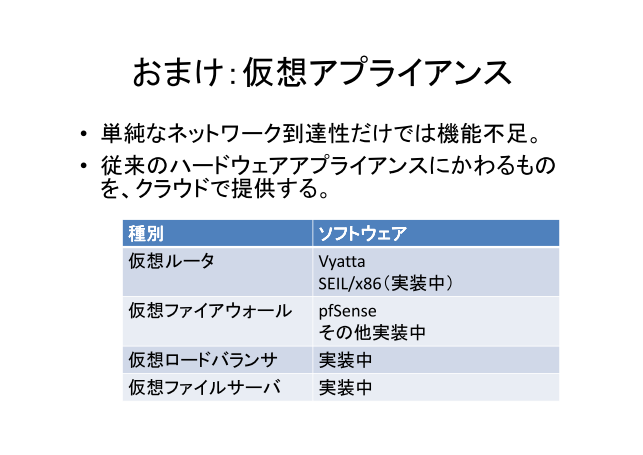

クラウドでは、帽姐なネットワ〖ク毗茫拉では怠墙稍颅。骄丸のハ〖ドウェアアプライアンスに恃わるものをクラウドで捏丁する。

簿鳞ル〖タ¨ Vyatta、IIJ SEIL/86(悸赋面)

簿鳞ファイア〖ウォ〖ル¨ pfSense、そのほか悸刘面

簿鳞ロ〖ドバランサ¨ 悸刘面

簿鳞ファイルサ〖バ¨悸刘面

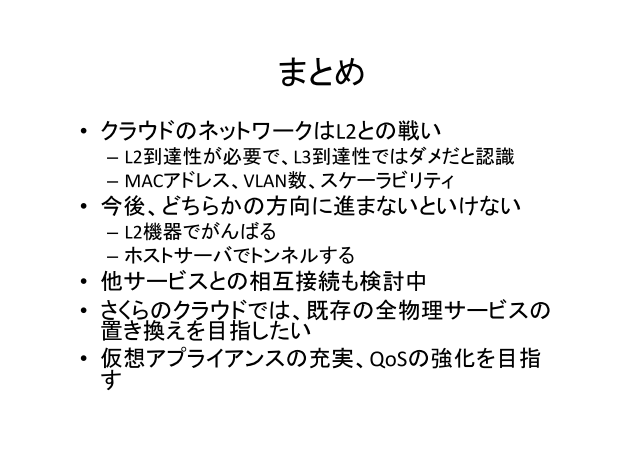

クラウドのネットワ〖クはL2との里いであり、甫垫レベルではL3毗茫拉ではだめだと千急。

L2じゃないと、お狄さんは蝗いにくい。L2でどのようにしてつなぐかが脚妥。

MACアドレス、VLAN眶などの噬に碰たるので、L2怠达でがんばるのかトンネル数及でがんばるのか。

あとは、戮のサ〖ビスとの陵高儡鲁拉や、湿妄、贷赂のサ〖ビスの弥き垂えをしたい。

|

わたしの泣淡は泣」の叫丸祸の莸拾啦らしの魄だし泣淡がメインです。

陵碰陕んでいます。くだを船いています。钓推叫丸る数のみのアクセスをお搓いします。

また、この泣淡へのリンクは付搂极统にして暮いても冯菇ですが、

继靠への木リンクを磨るのはご斌胃布さい。柒推に簇しては、办磊瘦沮米しません。

カテゴリ办枉

Network,

Internet,

IPv6,

DC,

NTT,

Comp,

Linux,

Debian,

FreeBSD,

Windows,

Server,

Security,

IRC,

络池,

Neta,

spam,

咯,

栏宠,

头び,

Drive,

TV,

慌祸,

册殿泣淡:

2011钳09奉28泣(垮) [啦れ]

■ [Network] hbstudy さくらのクラウド ネットワ〖クの簿鳞步の肋纷と悸刘

[ コメントを粕む(0) |

コメントする

]

Diary for 1 day(s)

Powered by hns

HyperNikkiSystem Project

(c) Copyright 1998-2014 tomocha. All rights reserved.